Anthropische Forschung zeigt, wie LLMs Text wahrnehmen

Forscher von Anthropic untersuchten die Fähigkeit von Claude 3.5 Haiku, zu entscheiden, wann eine Textzeile innerhalb einer festen Breite umgebrochen werden soll, eine Aufgabe, die erfordert, dass das Modell seine Position beim Schreiben verfolgt. Die Studie ergab das überraschende Ergebnis, dass Sprachmodelle interne Muster bilden, die dem räumlichen Bewusstsein ähneln, das Menschen nutzen, um ihren Standort im physischen Raum zu verfolgen.

Andreas Volpini hat über dieses Papier getwittert und eine Analogie zum Chunking von Inhalten für den KI-Verbrauch gezogen. Im weiteren Sinne fungiert sein Kommentar als Metapher dafür, wie sowohl Autoren als auch Modelle mit Strukturen umgehen und Kohärenz an den Grenzen finden, wo ein Segment endet und ein anderes beginnt.

In dieser Forschungsarbeit geht es jedoch nicht um das Lesen von Inhalten, sondern darum, Text zu generieren und herauszufinden, wo ein Zeilenumbruch eingefügt werden muss, um den Text in eine beliebige feste Breite einzupassen. Der Zweck bestand darin, besser zu verstehen, was in einem LLM vor sich geht, da es beim Schreiben die Textposition, die Wortwahl und die Zeilenumbruchgrenzen verfolgt.

Die Forscher erstellten eine experimentelle Aufgabe zum Generieren von Text mit einem Zeilenumbruch in einer bestimmten Breite. Der Zweck bestand darin, zu verstehen, wie Claude 3.5 Haiku entscheidet, welche Wörter in eine bestimmte Breite passen und wann ein Zeilenumbruch eingefügt wird, was erfordert, dass das Modell die aktuelle Position innerhalb der von ihm generierten Textzeile verfolgt.

Das Experiment zeigt, wie Sprachmodelle ohne explizite Programmierung oder Aufsicht Strukturen aus Mustern im Text lernen.

Die Linebreaking-Herausforderung

Bei der Zeilenumbruchaufgabe muss das Modell entscheiden, ob das nächste Wort in die aktuelle Zeile passt oder ob ein neues Wort beginnen muss. Um erfolgreich zu sein, muss das Modell die Zeilenbreitenbeschränkung lernen (die Regel, die begrenzt, wie viele Zeichen in eine Zeile passen, z. B. im physischen Raum auf einem Blatt Papier). Dazu muss das LLM die Anzahl der geschriebenen Zeichen verfolgen, berechnen, wie viele noch übrig sind, und entscheiden, ob das nächste Wort passt. Die Aufgabe erfordert logisches Denken, Gedächtnis und Planung. Die Forscher verwendeten Attributionsdiagramme, um zu visualisieren, wie das Modell diese Berechnungen koordiniert, und zeigten unterschiedliche interne Merkmale für die Zeichenanzahl, das nächste Wort und den Zeitpunkt, an dem ein Zeilenumbruch erforderlich ist.

Kontinuierliches Zählen

Die Forscher stellten fest, dass Claude 3.5 Haiku die Zählung von Linienzeichen nicht als schrittweises Zählen darstellt, sondern als eine glatte geometrische Struktur, die sich wie eine kontinuierlich gekrümmte Oberfläche verhält und es dem Modell ermöglicht, die Position fließend (im laufenden Betrieb) zu verfolgen, anstatt Symbol für Symbol zu zählen.

Interessant ist auch, dass sie herausgefunden haben, dass das LLM einen Grenzkopf (einen „Aufmerksamkeitskopf“) entwickelt hat, der für die Erkennung der Liniengrenze verantwortlich ist. Ein Aufmerksamkeitsmechanismus gewichtet die Wichtigkeit dessen, was berücksichtigt wird (Tokens). Ein Aufmerksamkeitskopf ist eine spezielle Komponente des Aufmerksamkeitsmechanismus eines LLM. Der Grenzkopf, der ein Aufmerksamkeitskopf ist, ist auf die enge Aufgabe spezialisiert, das Ende der Liniengrenze zu erkennen.

In der Forschungsarbeit heißt es:

„Ein wesentliches Merkmal der Darstellung von Zeilenzeichenzahlen besteht darin, dass der „Grenzkopf“ die Darstellung verdreht, sodass jede Zählung mit einer etwas größeren Zahl gepaart werden kann, was darauf hinweist, dass die Grenze nahe ist. Das heißt, es gibt eine lineare Abbildung QK, die die Zeichenzahlkurve entlang sich selbst verschiebt. Eine solche Aktion ist bei generischen Einbettungen des Kreises oder des Intervalls mit hoher Krümmung wie denen in dem von uns erstellten physikalischen Modell nicht zulässig. Sie ist jedoch sowohl in der Mannigfaltigkeit, die wir in Haiku beobachten, als auch, wie wir jetzt zeigen, vorhanden in der Fourier-Konstruktion.

Wie Grenzerkennung funktioniert

Die Forscher fanden heraus, dass Claude 3.5 Haiku durch den Vergleich zweier interner Signale erkennt, wann eine Textzeile fast das Ende erreicht:

- Wie viele Zeichen wurden bereits generiert und

- Wie lang soll die Leitung sein?

Die oben genannten Grenzaufmerksamkeitsköpfe entscheiden, auf welche Teile des Textes der Fokus gelegt werden soll. Einige dieser Köpfe sind darauf spezialisiert, zu erkennen, wann die Linie ihr Limit erreicht. Sie tun dies, indem sie die beiden internen Signale (die Zeichenanzahl und die maximale Zeilenbreite) leicht drehen oder aneinanderreihen, sodass sich die Aufmerksamkeit des Modells auf das Einfügen eines Zeilenumbruchs richtet, wenn sie nahezu übereinstimmen.

Die Forscher erklären:

„Um eine sich nähernde Liniengrenze zu erkennen, muss das Modell zwei Größen vergleichen: die aktuelle Zeichenanzahl und die Linienbreite. Wir finden Aufmerksamkeitsköpfe, deren QK-Matrix eine Zählmannigfaltigkeit dreht, um sie mit einem bestimmten Versatz an der anderen auszurichten, wodurch ein großes inneres Produkt entsteht, wenn die Differenz der Zählungen in einen Zielbereich fällt. Mehrere Köpfe mit unterschiedlichen Versätzen arbeiten zusammen, um die verbleibenden Zeichen genau abzuschätzen.“

Letzte Phase

In dieser Phase des Experiments hat das Modell bereits bestimmt, wie nah es an der Liniengrenze ist und wie lang das nächste Wort sein wird. Der letzte Schritt besteht darin, diese Informationen zu verwenden.

So wird es erklärt:

„Der letzte Schritt der Zeilenumbruchaufgabe besteht darin, die Schätzung der Zeilengrenze mit der Vorhersage des nächsten Wortes zu kombinieren, um zu bestimmen, ob das nächste Wort auf die Zeile passt oder ob die Zeile unterbrochen werden sollte.“

Die Forscher fanden heraus, dass bestimmte interne Funktionen im Modell aktiviert werden, wenn das nächste Wort dazu führen würde, dass die Linie ihre Grenze überschreitet, und so effektiv als Grenzdetektoren dienen. In diesem Fall erhöht das Modell die Wahrscheinlichkeit, ein Zeilenumbruchsymbol vorherzusagen, und verringert die Wahrscheinlichkeit, ein anderes Wort vorherzusagen. Andere Funktionen bewirken das Gegenteil: Sie werden aktiviert, wenn das Wort noch passt, wodurch die Wahrscheinlichkeit verringert wird, dass ein Zeilenumbruch eingefügt wird.

Zusammen balancieren diese beiden Kräfte, eine, die auf einen Zeilenumbruch drängt, und eine, die ihn zurückhält, aus, um die Entscheidung zu treffen.

Können Models visuelle Illusionen haben?

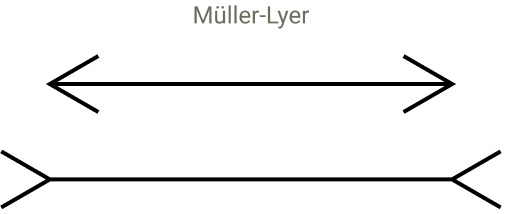

Der nächste Teil der Forschung ist irgendwie unglaublich, denn sie versuchten zu testen, ob das Modell anfällig für visuelle Täuschungen sein könnte, die zum Stolpern führen könnten. Sie begannen mit der Idee, wie Menschen durch visuelle Täuschungen getäuscht werden können, die eine falsche Perspektive darstellen und Linien gleicher Länge unterschiedlich lang erscheinen lassen, eine kürzer als die andere.

Screenshot einer visuellen Illusion

Die Forscher fügten künstliche Zeichen wie „@@“ ein, um zu sehen, wie sie das Positionsgefühl des Modells störten. Diese Tests verursachten Fehlausrichtungen in den internen Mustern des Modells, die es zur Positionsverfolgung verwendet, ähnlich wie visuelle Täuschungen, die die menschliche Wahrnehmung täuschen. Dies führte dazu, dass sich die Wahrnehmung der Liniengrenzen durch das Modell verschob, was zeigt, dass seine Wahrnehmung der Struktur vom Kontext und erlernten Mustern abhängt. Obwohl LLMs nicht sehen, erleben sie Verzerrungen in ihrer internen Organisation, ähnlich wie Menschen das, was sie sehen, falsch einschätzen, indem sie die relevanten Aufmerksamkeitsköpfe stören.

Sie erklärten:

„Wir stellen fest, dass es das vorhergesagte nächste Token moduliert und die Newline-Vorhersage stört! Wie vorhergesagt werden die relevanten Köpfe abgelenkt: Während bei der ursprünglichen Eingabeaufforderung die Köpfe von Newline zu Newline wechseln, kümmern sich die Köpfe in der geänderten Eingabeaufforderung auch um das @@.“

Sie fragten sich, ob die @@-Zeichen etwas Besonderes seien oder ob andere zufällige Zeichen die Fähigkeit des Modells beeinträchtigen würden, die Aufgabe erfolgreich abzuschließen. Daher führten sie einen Test mit 180 verschiedenen Sequenzen durch und stellten fest, dass die meisten davon die Fähigkeit des Modells, den Zeilenumbruchpunkt vorherzusagen, nicht beeinträchtigten. Sie fanden heraus, dass nur eine kleine Gruppe codebezogener Zeichen in der Lage war, die Aufmerksamkeit der betreffenden Personen abzulenken und den Zählvorgang zu stören.

LLMs haben eine visuelle Wahrnehmung für Text

Die Studie zeigt, wie sich textbasierte Merkmale innerhalb eines Sprachmodells zu glatten geometrischen Systemen entwickeln. Es zeigt sich auch, dass Modelle Symbole nicht nur verarbeiten, sondern daraus wahrnehmungsbasierte Karten erstellen. Dieser Teil über die Wahrnehmung ist für mich das wirklich Interessante an der Forschung. Sie kehren immer wieder zu Analogien im Zusammenhang mit der menschlichen Wahrnehmung zurück und wie diese Analogien immer wieder in das passen, was sie im LLM sehen.

Sie schreiben:

„Obwohl wir manchmal beschreiben, dass die frühen Schichten von Sprachmodellen für die „Detokenisierung“ der Eingabe verantwortlich sind, ist es vielleicht anschaulicher, dies als Wahrnehmung zu betrachten. Der Anfang des Modells ist in Wirklichkeit dafür verantwortlich, die Eingabe zu sehen, und ein Großteil der frühen Schaltkreise dient der Erfassung oder Wahrnehmung des Textes, ähnlich wie frühe Schichten in Visionsmodellen die Wahrnehmung auf niedriger Ebene implementieren.“

Dann schreiben sie etwas später:

„Die geometrischen und algorithmischen Muster, die wir beobachten, weisen aufschlussreiche Parallelen zur Wahrnehmung in biologischen neuronalen Systemen auf. … Diese Merkmale weisen eine Erweiterung auf – sie stellen immer größere Zeichenzahlen dar, die über immer größere Bereiche aktiviert werden – und spiegeln die Erweiterung der Zahlendarstellungen in biologischen Gehirnen wider. Darüber hinaus ist die Organisation der Merkmale auf einer niedrigdimensionalen Mannigfaltigkeit ein Beispiel für ein häufiges Motiv in der biologischen Kognition. Auch wenn die Analogien nicht perfekt sind, vermuten wir, dass es immer noch fruchtbare konzeptionelle Überschneidungen aus der verstärkten Zusammenarbeit zwischen Neurowissenschaften und Neurowissenschaften gibt Interpretierbarkeit.“

Auswirkungen auf SEO?

Arthur C. Clarke schrieb, dass fortschrittliche Technologie nicht von Magie zu unterscheiden sei. Ich denke, wenn man eine Technologie erst einmal verstanden hat, wird sie nachvollziehbarer und weniger magisch. Nicht jedes Wissen hat einen nützlichen Nutzen, und ich denke, dass es insofern nützlich ist, zu verstehen, wie ein LLM Inhalte wahrnimmt, als dass es nicht mehr magisch ist. Wird diese Forschung Sie zu einem besseren SEO machen? Es vertieft unser Verständnis dafür, wie Sprachmodelle die Inhaltsstruktur organisieren und interpretieren, macht sie verständlicher und weniger wie Magie.

Lesen Sie hier über die Forschung:

Wenn Modelle Mannigfaltigkeiten manipulieren: Die Geometrie einer Zählaufgabe

Ausgewähltes Bild von Shutterstock/Krot_Studio