BotNet: Wie das schnelle Wachstum von Bots das offene Web verändern könnte

Wie verändert das schnelle Wachstum von Bots das offene Web?

Mehr als die Hälfte des Web-Traffics kommt von Bots:

- Der Bad Bot Report 2024 von Imperva zeigt, dass im Jahr 2024 fast 50 % des gesamten Internetverkehrs nicht von Menschen stammten. Tendenz: rückläufig.1

- Das Radar von Cloudflare zeigt etwa 70 % menschlichen Traffic und 30 % von Bots.2

- Akami berichtet, dass 42 % des Traffics im Web von Bots stammen.3

Bisher haben Bots Informationen gesammelt, die Apps für Menschen besser machen. Aber eine neue Art wächst in der Population: Agenten-Bots.

Seit zwei Jahrzehnten optimieren wir Websites für GoogleBot. Bald könnten wir uns auf KI-Helfer konzentrieren, die als Vermittler zwischen Menschen und dem offenen Web fungieren.

Wir haben bereits mit Schema und Produkt-Feeds im Merchant Center von Google für das BotNet optimiert. XML-Sitemaps sind schon vor Jahrzehnten zum Standard geworden.

Auf der nächsten Ebene könnten wir separate Websites oder APIs für Agenten-Bots mit einem völlig neuen Marketing-Spielfeld haben.

Bildquelle: Lyna™

Bildquelle: Lyna™Agentisches Web

Da wir im offenen Web bald mehr Bot- als menschlichen Datenverkehr verzeichnen, ist es wichtig zu bedenken, dass Schätzungen zufolge etwa 65 % des Bot-Datenverkehrs böswillig sind.

Zu guten Bots gehören Scraper von Suchmaschinen, SEO-Tools, Sicherheitsschutz und natürlich KI-Crawler. Die Zahl beider Arten von Bots wächst, aber nur die guten sind wirklich nützlich.

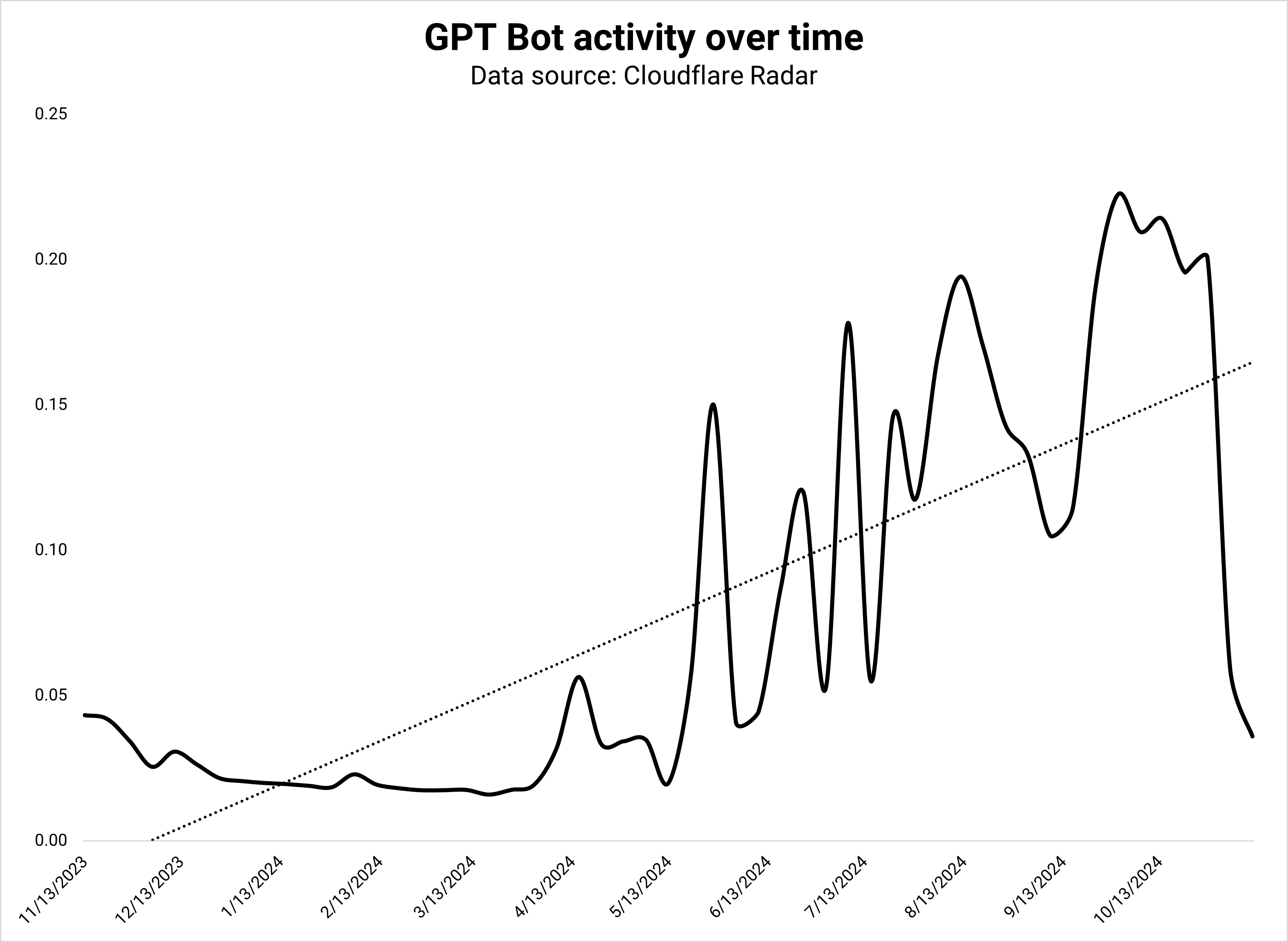

Im Vergleich zu den letzten sechs Monaten verzeichneten KI-Crawler ein Wachstum von 18 %, während Suchmaschinen um 10 % langsamer wurden. GoogleBot reduzierte die Aktivität gezielt um -1,6 %.

Der KI-Crawler von Google machte dies jedoch mit einem Plus von 1,4 % wett. GPT Bot war mit 3,8 % aller Anfragen der aktivste KI-Crawler – und wuchs um 12 %.

Der KI-Crawler von Google wuchs um 62 % und war für 3,7 % aller Bot-Anfragen verantwortlich. Angesichts seiner aktuellen Wachstumsrate dürfte der KI-Crawler von Google bald der aktivste im Web sein.4

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigHeutzutage verfolgen KI-Bots drei Ziele:

- Sammeln Sie Trainingsdaten.

- Erstellen Sie einen Suchindex, um LLM-Antworten (RAG) zu fundieren.

- Sammeln Sie Echtzeitdaten für Eingabeaufforderungen, die Aktualität erfordern.

Aber derzeit arbeiten alle großen KI-Entwickler an Agenten, die im Internet surfen und Maßnahmen für Benutzer ergreifen:

- Claude war mit seiner Produktfunktion „Computernutzung“ der Erste: „Entwickler können Claude anweisen, Computer so zu nutzen, wie Menschen es tun – indem sie auf einen Bildschirm schauen, einen Cursor bewegen, auf Schaltflächen klicken und Text eingeben.“5

- Googles Jarvis, „ein hilfreicher Begleiter, der für Sie im Internet surft“, wurde kürzlich versehentlich im Chrome Store gestartet.6

- OpenAI arbeitet mit „Operator“, ebenfalls einem Agenten, der für Sie Maßnahmen ergreift.7

Ich sehe drei mögliche Ergebnisse:

- Agenten steigern den Bot-Verkehr im offenen Web erheblich, indem sie Websites crawlen und besuchen.

- Agenten verwenden APIs, um Informationen abzurufen.

- Agenten arbeiten auf ihrer Plattform, was bedeutet, dass der Operator nur Daten von ChatGPT verwendet, anstatt seine eigenen zu sammeln.

Ich halte eine Mischung aus allen dreien für am wahrscheinlichsten, mit der Folge, dass der Bot-Verkehr deutlich zunehmen würde.

Wenn sich das bewahrheitet, werden Unternehmen zunehmend separate Versionen ihrer Website für Bots erstellen, die auf Geschwindigkeit und strukturierte Daten ausgerichtet sind. „Konzentrieren Sie sich nur auf den Benutzer“ wird zu „Konzentrieren Sie sich nur auf die Agenten“.

In gewisser Weise ist ChatGPT Search bereits ein Agent, der das Web für Menschen durchsucht und kuratiert. Aber wenn die Makler ihr Versprechen halten, können Sie noch viel mehr erwarten.

OpenAI-CEO Sam Altman sagte in seinem jüngsten Reddit AMA: „Ich denke, der nächste große Durchbruch werden Agenten sein.“

Was machen Menschen, während Bots das Web erobern?

Internet-Einführung

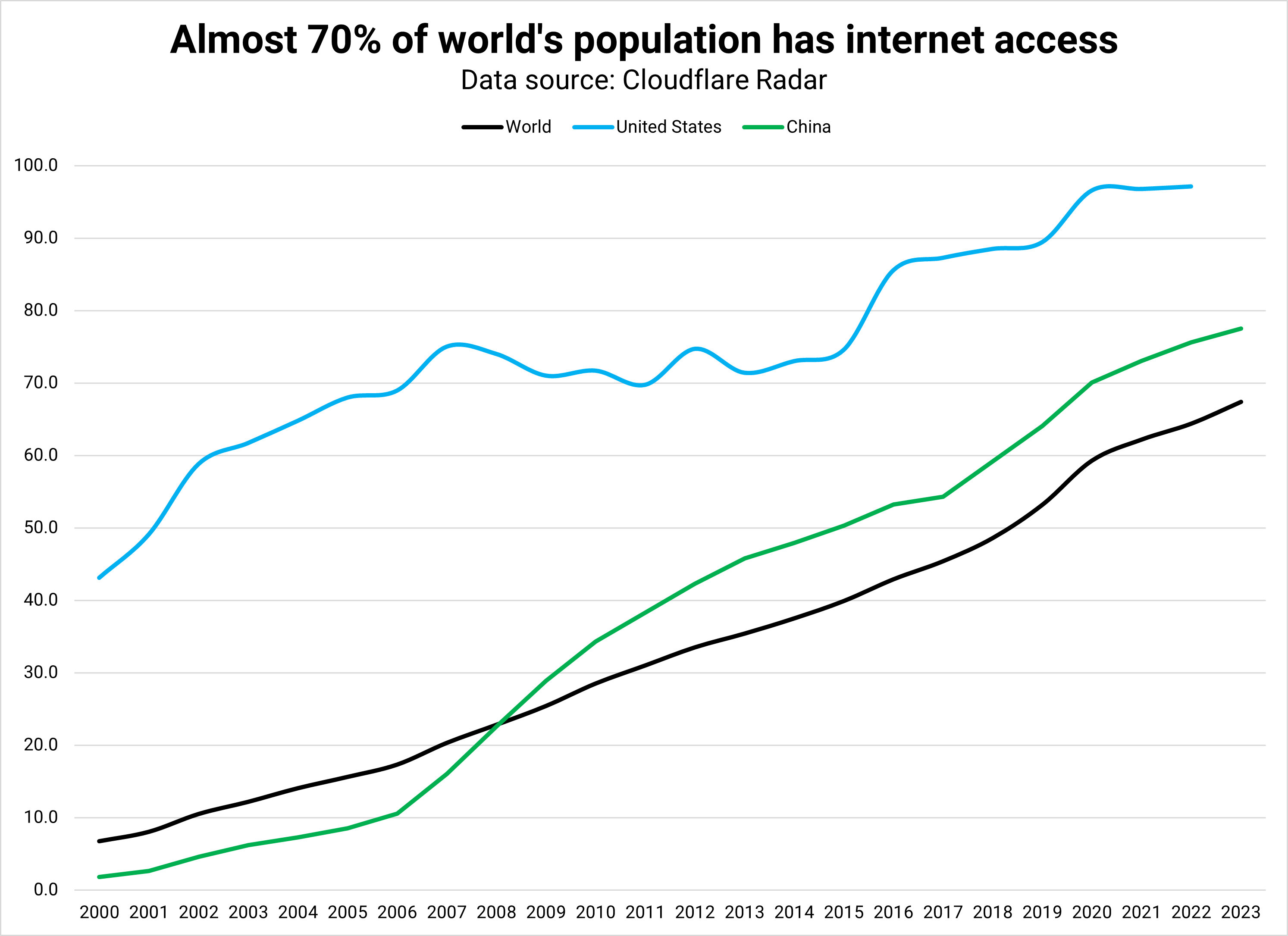

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigEs ist unwahrscheinlich, dass Menschen ganz aufhören, im Internet zu surfen.

Selbst mit KI-Antworten in der Suche und Suchfunktionen in KI-Chatbots möchten Menschen immer noch KI-Aussagen überprüfen, sich zufällig inspirieren lassen (Serendipity) oder Antworten von anderen Menschen einholen (Reddit).

Aber wenn die Bots gut genug sind, wird sich der Vorgang des Navigierens zur Suche wahrscheinlich in Eingabeaufforderungen auflösen.

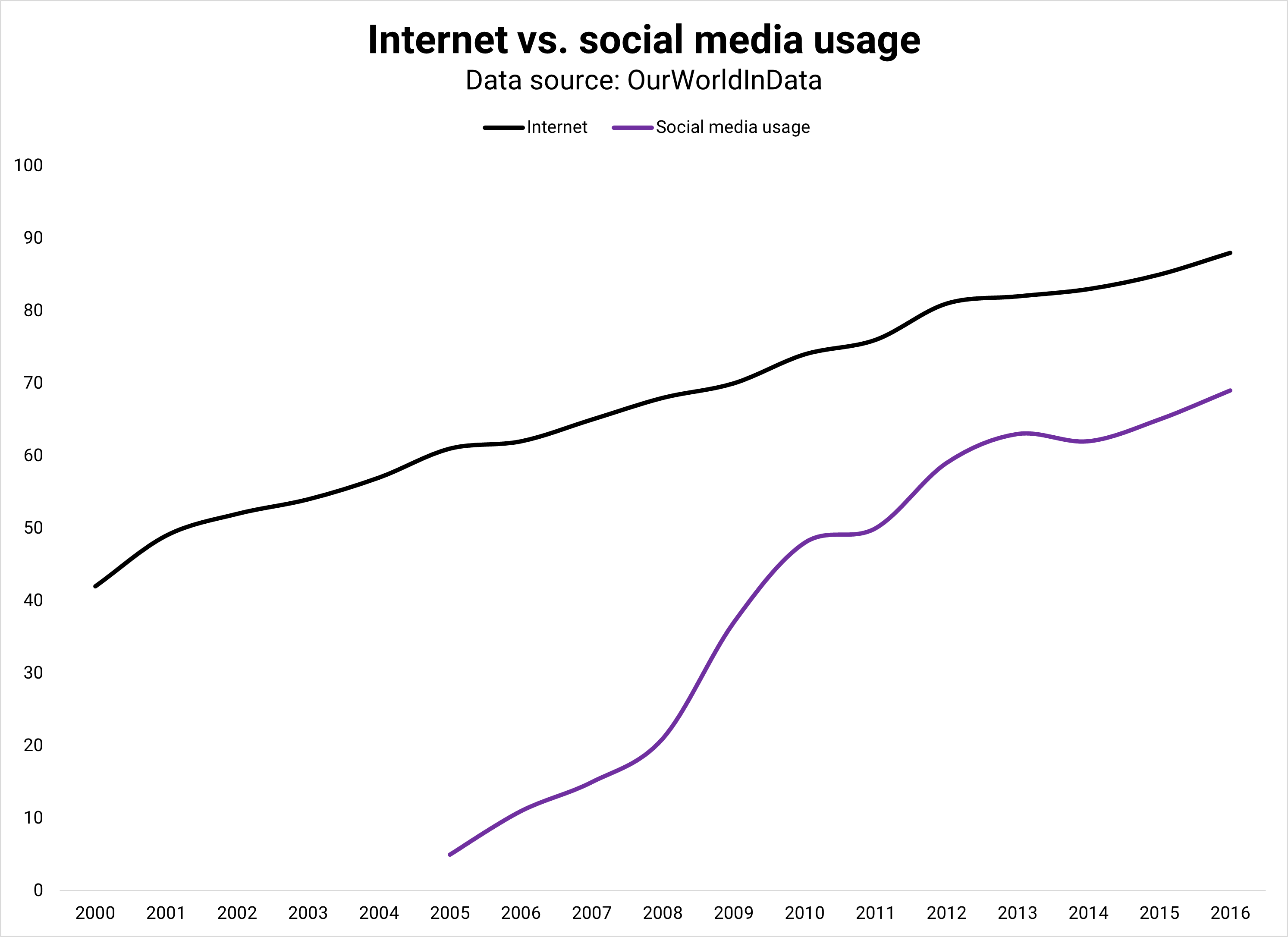

Es gibt Raum für Wachstum beim menschlichen Verkehr: 70 % der Weltbevölkerung verfügten im Jahr 2023 über einen Internetzugang. Beim aktuellen Tempo (~7 % im Jahresvergleich) würde bis 2030 die ganze Welt über einen Internetzugang verfügen.

Trotz der zunehmenden Verbreitung des Internets ist der menschliche Datenverkehr in den letzten drei Jahren jedoch stagniert (siehe Cloudflare-Statistiken). KI-Crawler wachsen viel schneller (18 %), und Agenten könnten es noch schneller machen.

Bildnachweis: Kevin Indig

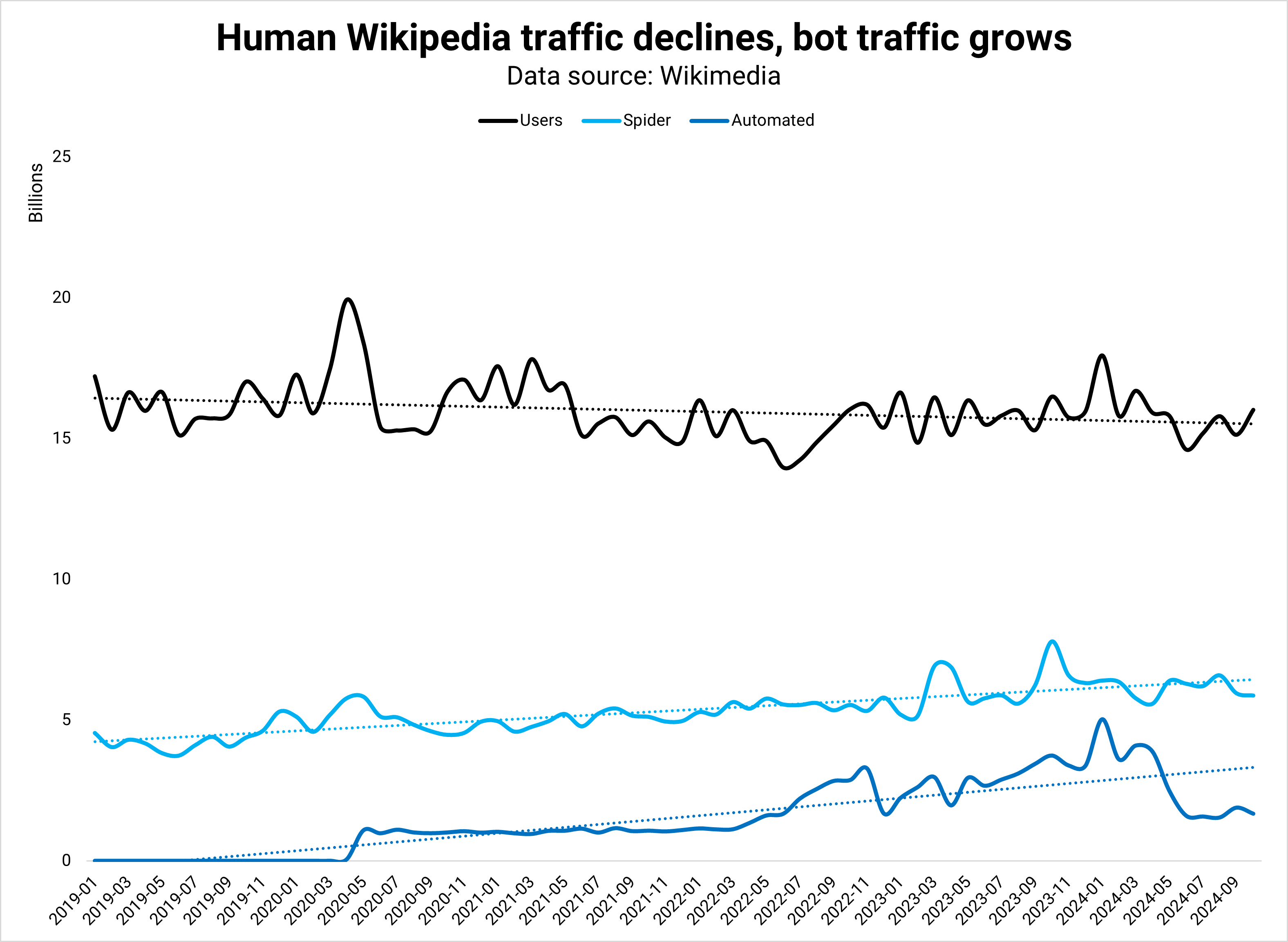

Bildnachweis: Kevin IndigDie menschlichen Anfragen an Wikipedia, die größte Website im Internet, stagnieren seit 2019.8

Der Grund dafür ist, dass sich die Aufmerksamkeit der Menschen auf soziale Plattformen verlagert, insbesondere bei jüngeren Generationen. Während die Bots das offene Netz erobern, fliehen die Menschen in Verlobungszentren.

Marketing

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigIn ferner Zukunft könnten gute Bots zu gleichberechtigten Bürgern der offenen Web-Nation werden, da immer mehr Menschen Zeit auf geschlossenen sozialen Plattformen verbringen und agentische LLMs das ohnehin schon schnelle Wachstum des Bot-Verkehrs steigern. Wenn diese Theorie zutrifft, was bedeutet das für das Marketing und insbesondere für SEO?

Stellen Sie sich vor, Sie buchen eine Reise. Anstatt Google oder Booking zu durchsuchen, teilen Sie Ihrem Agenten mit, wohin und wann Sie reisen möchten.

Basierend auf dem, was er über Ihre Präferenzen weiß, kuratiert Ihr Agent drei Optionen für Flüge und Hotels auf der Plattform Ihrer Wahl.

Wenn Sie einen Flug auswählen, wird dieser Ihrem Kalender hinzugefügt und die Tickets befinden sich in Ihrem Posteingang. Sie müssen nicht zur Kasse gehen. Der Makler erledigt alles für Sie. Sie könnten das gleiche Szenario auf E-Commerce oder Software anwenden.

Angesichts der Tatsache, dass Unternehmen wie Google bereits heute über die Möglichkeiten verfügen, dies zu erreichen, lohnt es sich, darüber nachzudenken, was in dieser Vision konstant bleiben würde, was sich ändern würde und was an Bedeutung verlieren würde.

Konstante

Bots benötigen kein CSS oder Heldenbilder. Das Tarnen Ihrer Website für LLM-Crawler hat keine Nachteile, daher besteht die Möglichkeit, dass Websites den Bots eine Barebone-Version anzeigen.

Eine Reihe von Fähigkeiten, die auch in Zukunft konstant bleiben, ist technisches SEO: Crawlbarkeit, (Server-)Geschwindigkeit, interne Verlinkung und strukturierte Daten.

Ändern

Ein offenes Agentennetz bietet viel bessere Möglichkeiten zur Anzeigenausrichtung, da Bots ihre Besitzer in- und auswendig kennen.

Menschen werden Kaufentscheidungen viel schneller treffen, da ihre Agenten ihnen alle benötigten Informationen geben und ihre Vorlieben kennen.

Werbekosten sinken deutlich und bieten noch höhere Renditen als ohnehin schon.

Da Bots alles in Sekundenschnelle übersetzen können, sind Lokalisierung und internationaler Vertrieb kein Problem mehr. Menschen können bei jedem und überall einkaufen – nur mit Einschränkungen durch Versand und Lagerbestand. Die Weltwirtschaft öffnet sich noch weiter.

Wenn wir es richtig machen, könnten Agenten die ultimativen Hüter der Privatsphäre sein: Niemand hat so viele Daten über Sie wie sie, aber Sie können steuern, wie viele sie weitergeben.

Agenten kennen Sie, müssen diese Informationen aber nicht mit anderen teilen. Möglicherweise teilen wir noch mehr Daten mit ihnen und drehen das Wertschwungrad von Daten → Verständnis → Ergebnisse → Daten → Wert → Ergebnisse → usw.

Auf der anderen Seite müssen wir Abwehrkräfte gegen betrügerische Bots aufbauen, indem wir in einem robots.txt 2.0-ähnlichen Format neu definieren, was Bots tun dürfen. Cybersicherheit ist noch wichtiger, aber auch komplexer geworden, da schlechte Bots gute Bots viel besser nachahmen können.

Wir müssen die Umweltauswirkungen eines höheren Energieverbrauchs durch höheren Bot-Verkehr herausfinden.

Es bleibt zu hoffen, dass Bots effizienter sind und daher insgesamt weniger Web-Traffic verursachen als Menschen. Dies würde die Energieflut, die LLMs bereits verursachen, zumindest etwas ausgleichen.

Wichtig

Das Bot-freundlichste Informationsformat ist roh und strukturiert: XML-, RSS- und API-Feeds. Wir haben bereits Produkt-Feeds und XML-Sitemaps an Google gesendet, aber Agenten werden mehr wollen.

Webdesign wird in Zukunft weniger wichtig sein, und vielleicht ist das auch in Ordnung, da die meisten Websites ohnehin sehr ähnlich aussehen.

Das Feed-Design wird immer wichtiger: Welche Informationen sollen in Feeds aufgenommen werden, wie viele, wie oft werden sie aktualisiert und welche Anfragen werden an Bots zurückgesendet.

Vermarkter werden viel mehr Zeit damit verbringen, nachzuentwickeln, wie Gespräche mit Chatbots aussehen. Bots werden wahrscheinlich eine Blackbox wie der Algorithmus von Google sein, aber Werbung könnte Licht in das bringen, was die Leute am meisten fragen.

Beziehungen

In der Zukunft der Agenten ist es schwierig, Kunden zum Wechseln zu bewegen, sobald sie sich für eine Marke entschieden haben, die ihnen gefällt, bis sie eine schlechte Erfahrung machen.

Ein wichtiger Marketinghebel wird daher darin bestehen, Kunden mit Kampagnen wie Rabatten und exklusiven Angeboten dazu zu bringen, Ihre Marke auszuprobieren.

Sobald Sie überzeugt sind und signalisieren, dass Ihr Produkt besser ist, geht es darum, Benutzer davon zu überzeugen, es auszuprobieren. Offensichtlich funktioniert das heute schon.

Da es so viele Möglichkeiten gibt, Nutzer vor dem Kauf organisch für ein bestimmtes Produkt zu werben und davon zu überzeugen, haben wir viel mehr Einfluss auf den Kauf.

Aber in Zukunft könnten Agenten diese Entscheidungen für Benutzer treffen. Vermarkter werden mehr Zeit mit dem Aufbau von Beziehungen, dem Aufbau von Markenbekanntheit und der Beeinflussung althergebrachter Marketingfaktoren wie Preisgestaltung, Vertrieb (Versand) und Differenzierung verbringen.

1 Bad-Bot-Bericht 2024

2 Cloudflare Radar: Verkehrstrends

3 Bots machen 42 % des gesamten Web-Traffics aus; Fast zwei Drittel sind böswillig

4 Cloudflare Radar: Daten-Explorer

5 Einführung in die Computernutzung, ein neues Claude 3.5-Sonett und Claude 3.5-Haiku

6 Die Existenz der Jarvis AI-Erweiterung von Google ist im Chrome Store durchgesickert

7 OpenAI steht kurz vor der Einführung des AI Agent Tools zur Automatisierung von Aufgaben für Benutzer

8 Siteviews-Analyse

Ausgewähltes Bild: Paulo Bobita/Search Engine Journal