Google Search Central APAC 2025: Alles ab Tag 2

Der zweite Tag der Google Search Central Live APAC 2025 begann mit einem kurzen Zusammenhang mit dem tiefen Eintauchen am Vorteil des Vorteils in das Kriechen, bevor er sich direkt in die Indexierung bewegte.

Cherry Prommawin wurde eröffnet, indem er uns durchgeht, wie Google HTML analysiert und die wichtigsten Phasen der Indexierung hervorhebt:

- HTML Parsing

- Rendering und JavaScript -Ausführung

- Deduplizierung

- Feature -Extraktion

- Signalextraktion

Dadurch wurde das Thema für den Rest des Tages festgelegt.

Cherry stellte fest, dass Google zuerst die RAW -HTML in ein DOM normalisiert, dann nach Header- und Navigationselementen sucht und feststellt, welcher Abschnitt den Hauptinhalt enthält. Während dieses Prozesses extrahiert es auch Elemente wie Rel = Canonical, Hreflang, Links und Anker und Meta-Robots-Tags.

„Es gibt keine Präferenz zwischen reaktionsschnellen Websites und dynamischen/adaptiven Websites. Google versucht nicht, dies zu erkennen und hat keine bevorzugte Gewichtung.“

Kirschprommawin

Die Links bleiben für die Struktur des Webs sowohl für die Entdeckung als auch für die Rangliste von zentraler Bedeutung:

„Links sind immer noch ein wichtiger Bestandteil des Internets und werden verwendet, um neue Seiten zu entdecken und die Standortstruktur zu bestimmen, und wir verwenden sie für das Ranking.“

Kirschprommawin

Kontrolle der Indizierung mit Roboternregeln

Gary Illyes hat klargestellt, wo Robots.txt und Robots -Meta -Tags in den Fluss passen:

- Robots.txt Kontrolliert, was Crawlers holen können.

- Meta -Roboter -Tags Steuern Sie, wie diese abgerufenen Daten stromabwärts verwendet werden.

Er hob mehrere weniger bekannte Richtlinien hervor:

- keiner – Äquivalent zu

noindex,nofollowkombiniert zu einer einzigen Regel. Gibt es einen Vorteil dafür? Wenn Sie funktionell identisch sind, kann die Verwendung einer Anweisung anstelle von zwei die Tag -Management vereinfachen. - Notranslate – Wenn Chrome festgelegt wird, bietet Chrome nicht mehr an, die Seite zu übersetzen.

- NoimageIndex – gilt auch für Video -Vermögenswerte.

- Nicht verfügbar – Obwohl es von Ingenieuren vorgestellt wurde, die seitdem weitergezogen sind, funktioniert es immer noch. Dies könnte nützlich sein, um zeitsensitive Blog -Beiträge wie limitierte Angebote und Werbeaktionen abzubauen, sodass sie nicht in den KI -Funktionen von Google bestehen und die Benutzer irreführen oder die Markenwahrnehmung schaden.

Verstehen, was auf einer Seite steht

Gary Illyes betonte, dass der Hauptinhalt, wie durch Googles hochwertige Rater -Richtlinien definiert, definiert. ist das kritischste Element für das Kriechen und Indizieren. Es können Text, Bilder, Videos oder reiche Merkmale wie Taschenrechner sein.

Er zeigte, wie das Umschalten eines Themas in den Hauptinhaltsbereich die Rangliste steigern kann.

In einem Beispiel führte eine bewegliche Verweise auf „Hugo 7“ von einer Seitenleiste in den zentralen (Haupt-) Gehalt zu einer messbaren Steigerung der Sichtbarkeit.

„Wenn Sie für bestimmte Dinge rangieren möchten, legen Sie diese Wörter und Themen an wichtige Stellen (auf der Seite)”

Gary Illyes

Tokenisierung für die Suche

Sie können RAW HTML nicht in einen durchsuchbaren Index im Maßstab einleiten. Google unterteilt es in „Token“, individuelle Wörter oder Phrasen und speichert diejenigen in seinem Index. Das erste HTML -Segmentierungssystem stammt aus dem Tokyo Engineering Office von Google aus dem Jahr 2001 und dieselben Tokenisierungsmethoden mit ihren KI -Produkten, da „Warum das Rad neu erfinden“.

Wenn der Hauptinhalt dünn oder niedrig ist, was Google als „Soft 404“ bezeichnet, wird er mit einem Kernstück -Annotation gekennzeichnet, um zu zeigen, dass dieser Mangel im Mittelpunkt der Seite ist, nicht nur in einem Randabschnitt.

Handhabung von Web -Duplikation

Bild vom Autor, Juli 2025

Bild vom Autor, Juli 2025Cherry Prommawin erklärte die Deduplizierung in drei Fokusbereichen:

- Clustering – Verwenden von Umleitungen, Ähnlichkeiten inhaltlich und rel = kanonisch für Gruppen -Duplikatseiten.

- Inhaltsprüfungen – Prüfsummen, die die Kesselplatte ignorieren und viele Soft -Datei -Seiten fangen. Beachten Sie, dass Softfehler einen ganzen Cluster senken können.

- Lokalisierung – Wenn Seiten nur je nach Gebietsschema (zum Beispiel über Geo -Redirekten) unterscheiden, überbrückt Hreflang sie ohne Strafe.

Sie kontrastierte dauerhafte versus vorübergehende Weiterleitungen: Beide spielen eine Rolle beim Kriechen und beim Clustering, aber nur dauerhafte Weiterleitungen Einfluss, welche URL als kanonisch des Clusters ausgewählt wird.

Google priorisiert zuerst das Entführungsrisiko, die Benutzererfahrung zweitens und Site-Eigentümersignale (z. B. Ihr Rel = Canonical) bei der Auswahl der repräsentativen URL.

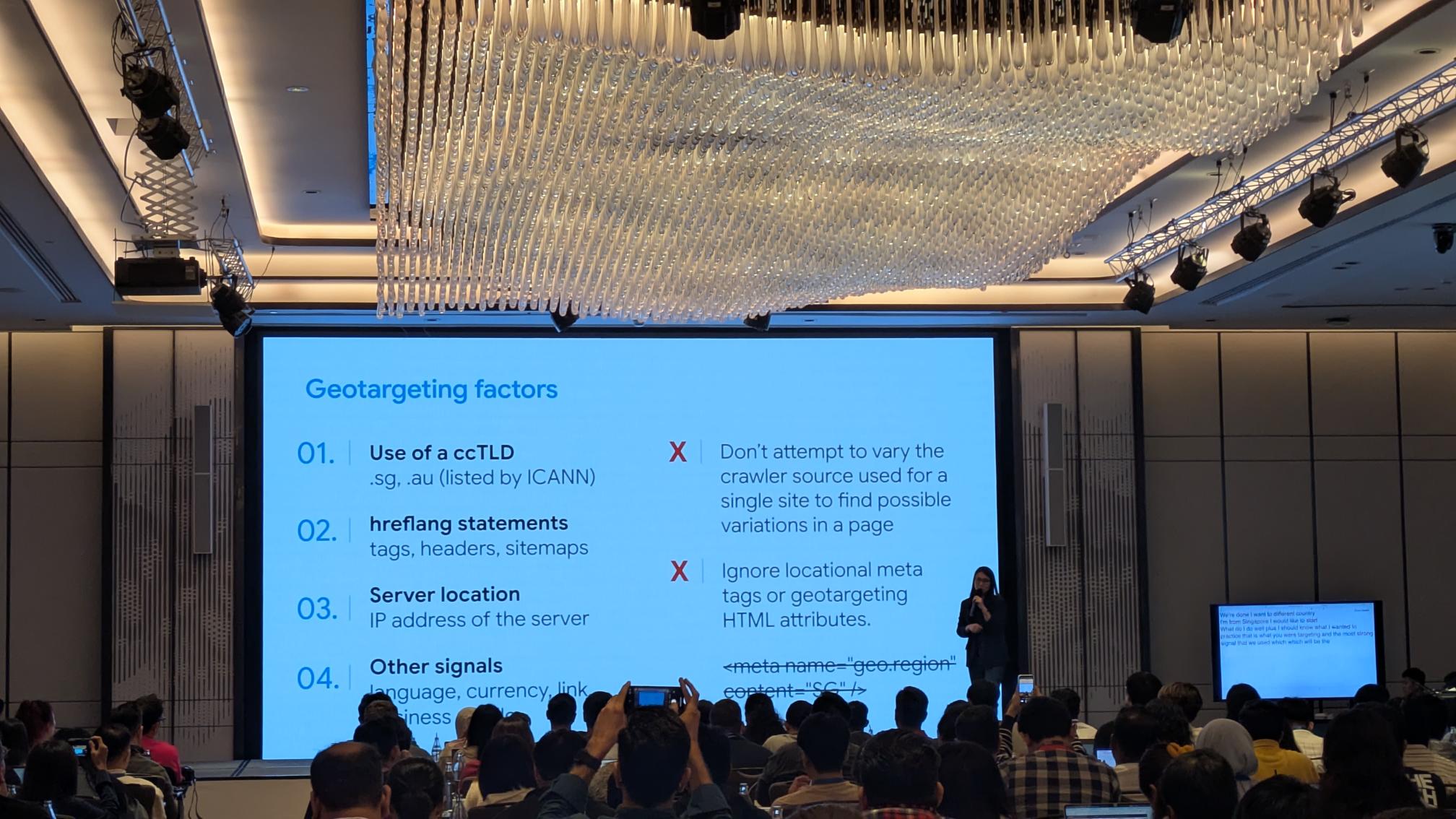

Geotargeting

Mit GeoTargeting können Sie Google für welches Land oder für Regionen Ihr Inhalt am relevantesten signalisieren, und es funktioniert anders als einfaches Sprachziel. Cherry Prommawin betonte, dass Sie nicht doppelte Inhalte auf zwei landesspezifischen Websites verbergen müssen. Hreflang wird diese Alternativen für Sie abwickeln.

Bild vom Autor, Juli 2025

Bild vom Autor, Juli 2025Wenn Sie den doppelten Inhalt mehrerer regionaler URLs ohne Lokalisierung bedienen, riskieren Sie, sowohl Crawler als auch Benutzer zu verwirren. Stellen Sie sicher, dass jede Version einzigartige, lokalisierte Inhalte auf ihr spezifisches Publikum zugeschnitten ist.

Die primären Geotargeting -Signale, die Google verwendet, sind:

- Country -Code Top -Level -Domäne (CCTLD) – Domänen wie .sg oder .au geben das Zielland an.

- Hreflang -Anmerkungen – Verwenden Tags, HTTP -Header oder Sitemap -Einträge, um Sprache und regionale Alternativen zu deklarieren.

- Serverstandort – Die IP -Adresse oder der Hosting -Standort Ihres Servers können als geografischer Hinweis dienen.

- Zusätzliche lokale Signalewie zum Beispiel Sprache und Währung auf der Seite, Links von anderen regionalen Websites und Signale aus Ihrem lokalen Geschäftsprofil verstärken Ihre Zielregion.

Durch die Kombination dieser Signale mit wirklich lokalisierten Inhalten helfen Sie Google, der richtigen Version Ihrer Website den richtigen Benutzern zu bedienen – und vermeiden Sie die Fallstricke unbeabsichtigter Duplikat -in -in -in -Kontent -Cluster.

Strukturierte Daten und Medien

Gary Illyes führte die Feature -Extraktionsphase ein, die nach der Deduplizierung ausgeführt wird und rechnerisch teuer ist. Es beginnt mit HTML und startet dann separate, asynchrone Medienindizierung für Bilder und Videos.

Wenn sich Ihr HTML im Index befindet, Ihre Medien nicht sind, bedeutet dies einfach, dass die Medienpipeline noch funktioniert.

Die Sitzungen in dieser Strecke enthielten:

- Strukturierte Daten mit William Prabowo

- Verwenden von Bildern mit Ian Huang

- Benutzer mit Video mit William Prabowo einbeziehen

Fragen und Antworten zum Schema

Das Schema-Markup kann Google helfen, die Beziehungen zwischen Unternehmen zu verstehen und LLM-gesteuerte Funktionen zu ermöglichen. Übermäßiges oder überflüssiges Schema fügt jedoch nur die Seitenblähung hinzu und hat keine zusätzlichen Ranking -Vorteile.

Und Schema wird nicht als Teil des Ranking -Prozesses verwendet.

Berechnung von Signalen

Während der Signalextraktion, auch Teil der Indexierung, berechnet Google eine Mischung aus:

- Indirekte Signale (Links, Erwähnungen nach anderen Seiten)

- Direkte Signale (On -Page -Wörter und Placements)

Bild vom Autor, Juli 2025

Bild vom Autor, Juli 2025Gary bestätigte, dass Google PageRank immer noch intern verwendet. Es ist nicht der genaue Algorithmus aus dem Weißbuch von 1996, aber es trägt denselben Namen.

Spam umgehen

Die Systeme von Google identifizieren täglich rund 40 Milliarden Spam -Seiten, die von ihrem LLM -basierten „Spambrain“ betrieben werden.

Bild vom Autor, Juli 2025

Bild vom Autor, Juli 2025Darüber hinaus betonte Gary, dass EEAT kein Indizier- oder Ranking -Signal ist. Es ist ein Erklärungsprinzip, keine berechnete Metrik.

Entscheidung, was indiziert wird

Die Indexauswahl ist auf Qualität zurückzuführen, definiert als eine Kombination aus Vertrauenswürdigkeit und Nutzen für Endbenutzer. Die Seiten werden aus dem Index für eindeutige negative Signale fallen gelassen:

noindexRichtlinien- Abgelaufener oder zeitlich begrenzter Inhalte

- Weiche 404 und durchläufte Duplikate

- Reine Spam- oder Politikverstöße

Wenn eine Seite gekrabbelt, aber nicht indiziert wurde, besteht das Mittel zur Verbesserung der Inhaltsqualität. Die interne Verknüpfung kann helfen, aber nur insofern, da es die Seite wirklich nützlicher macht. Das Ziel von Google ist es, Benutzerverbesserungen zu belohnen, nicht die Signalmanipulation.

Google ist es egal, ob Ihre Bilder mit AI-generiert sind

AI-generierte Bilder sind in Marketing-, Bildungs- und Design-Workflows gemeinsam geworden. Diese Grafiken werden von tiefen Lernmodellen erzeugt, die auf massiven Bildsammlungen ausgebildet sind.

Während der Sitzung skizzierte Huang, dass Google es egal ist, ob Ihre Bilder von KI oder Menschen generiert werden, solange sie die von Ihnen beabsichtigten Informationen genau und effektiv vermitteln.

Solange Bilder verständlich sind, sind ihre KI -Ursprünge irrelevant. Das Hauptziel ist eine effektive Kommunikation mit Ihrem Publikum.

Huang hob ein Beispiel für ein KI -Bild hervor, das das Google -Team am ersten Tag der Konferenz verwendet hat, das bei enger Betrachtung einige visuelle Fehler hat, aber als „Requisite“ war die Aufgabe, eine Zeitleiste darzustellen und war nicht der Hauptinhalt der Folie, sodass diese Fehler keine Rolle spielen.

Bild vom Autor, Juli 2025

Bild vom Autor, Juli 2025Wir können einen ähnlichen Ansatz für die Verwendung von AI-generierten Bildern verfolgen. Wenn das Bild die Nachricht vermittelt und nicht der Hauptinhalt der Seite ist, führen kleinere Probleme nicht zu einer Bestrafung und werden im Allgemeinen auch nicht mit AI-generierte Bilder verwendet.

Bilder sollten sich einer schnellen Übersicht unterziehen, um offensichtliche Fehler zu ermitteln, die Produktionsfehler verhindern können. Die fortlaufende Aufsicht ist nach wie vor, um das Vertrauen in Ihre Grafiken aufrechtzuerhalten und die Integrität Ihrer Marke zu schützen.

Google Trends API wurde angekündigt

Schließlich stellten Daniel Waisberg und Hadas Jacobi die neue Google Trends API (Alpha) vor. Zu den wichtigsten Funktionen der neuen API gehören:

- Konsequent skalierte Suchinteressendaten, die bei Änderungen von Abfragen nicht neu kalibrieren.

- Ein fünfjähriges Rollfenster, das vor bis zu 48 Stunden für saisonale und historische Vergleiche aktualisiert wurde.

- Flexible Zeitaggregation (wöchentlich, monatlich, jährlich).

- Region und Subregion -Aufschlüsse.

Dies eröffnet eine Welt der programmatischen Trendanalyse mit zuverlässigen, vergleichbaren Metriken im Laufe der Zeit.

Das endet am zweiten Tag. Morgen berichten wir über den letzten Tag drei bei Google Search Central Live mit weiteren Nachrichten und Erkenntnissen.

Weitere Ressourcen:

- Benötigen wir ein separates Rahmen für Geo/AEO? Google sagt wahrscheinlich nicht

- Google Search Central APAC 2025: Alles ab Tag 1

- Der Zustand der KI im Marketing

Ausgewähltes Bild: Dan Taylor/Salt.Agency