Schauen wir uns in einen Antwortmotor an und sehen, wie Genai die Gewinner auswählt

Stellen Sie eine Frage in Chatgpt, Verwirrung, Gemini oder Copilot, und die Antwort erscheint in Sekunden. Es fühlt sich mühelos an. Aber unter der Motorhaube gibt es keine Magie. Es passiert einen Kampf.

Dies ist der Teil der Pipeline, in dem sich Ihr Inhalt in einem Messerkampf mit jedem anderen Kandidaten befindet. Jede Passage im Index möchte diejenige sein, die das Modell auswählt.

Für Seos ist dies ein neues Schlachtfeld. Bei der traditionellen SEO ging es um eine Rangliste auf einer Ergebnisseite. Jetzt findet der Wettbewerb in einem Antwortauswahlsystem statt. Und wenn Sie Sichtbarkeit wünschen, müssen Sie verstehen, wie dieses System funktioniert.

Bildnachweis: Duane Forrester

Bildnachweis: Duane ForresterDie Antwortauswahlphase

Dies krabbelt, indiziert oder in eine Vektordatenbank eingebettet. Dieser Teil erfolgt vor der Anfrage. Die Auswahl der Antwort tritt ein, nachdem ein Benutzer eine Frage gestellt hat. Das System hat bereits Content Chunk, eingebettet und gespeichert. Was es tun muss, ist, Kandidatenpassagen zu finden, sie zu bewerten und zu entscheiden, welche in das Modell für die Generation übergeben werden sollen.

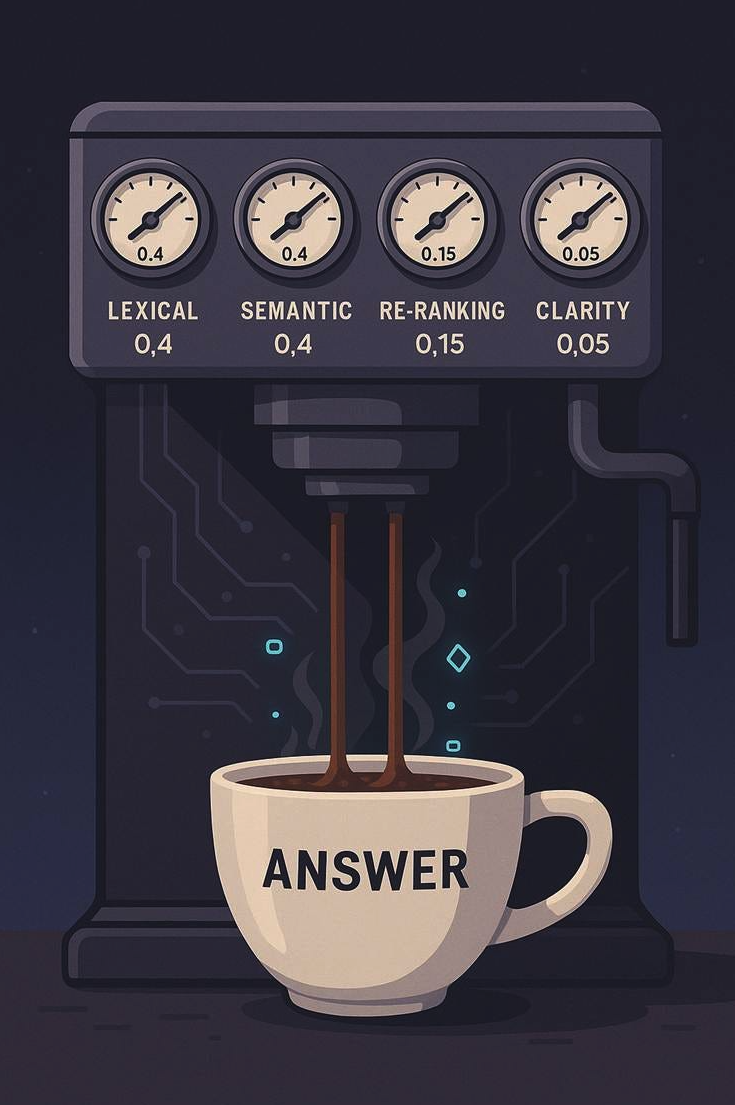

Jede moderne KI-Suchpipeline verwendet dieselben drei Stufen (über vier Schritte hinweg): Abruf-, Wiederholungs- und Klarheitsüberprüfungen. Jede Stufe ist wichtig. Jeder trägt Gewicht. Und während jede Plattform über ein eigenes Rezept verfügt (die Gewichtung, die in jedem Schritt/jeder Phase zugewiesen wird), gibt die Forschung uns genügend Sichtbarkeit, um einen realistischen Ausgangspunkt zu skizzieren. Im Grunde genommen unser eigenes Modell aufzubauen, um zumindest teilweise zu replizieren, was los ist.

Die Grundlinie des Baumeisters

Wenn Sie Ihr eigenes LLM-basierter Suchsystem erstellen würden, müssten Sie ihm sagen, wie viel jede Stufe zählt. Das bedeutet, normalisierte Gewichte zuzuordnen, die einem summieren.

Ein verteidigbarer, forschungsgeformter Stapel könnte so aussehen:

- Lexikaler Abruf (Schlüsselwörter, BM25): 0,4.

- Semantisches Abruf (Einbettungen, Bedeutung): 0,4.

- Neuranging (Cross-Coder-Wertung): 0,15.

- Klarheit und strukturelle Boosts: 0,05.

Jedes größere KI -System hat eine eigene proprietäre Mischung, aber sie brauen alle im Wesentlichen aus denselben Kernzutaten. Was ich Ihnen hier zeige, ist der durchschnittliche Ausgangspunkt für ein Unternehmenssuchsystem, nicht genau das, mit dem Chatgpt, Verwirrung, Claude, Copilot oder Gemini arbeiten. Wir werden diese Gewichte nie kennen.

Hybrid stellt die Branche aus. Weaviate Hybridsuche Alpha -Parameter stand auf 0,5, ein gleiches Gleichgewicht zwischen dem Schlüsselwort -Matching und den Einbettungen. Pinecone lehrt den gleichen Standard in seiner Hybridübersicht.

Das erneute Ranging erhält 0,15, da es nur für die kurze Liste gilt. Die Auswirkung ist jedoch nachgewiesen: „Durchgangsranger mit Bert“ zeigte große Genauigkeitsergebnisse, als Bert beim Abruf von BM25 geschichtet wurde.

Klarheit erhält 0,05. Es ist klein, aber real. Eine Passage, die mit der Antwort führt, ist mit Fakten dicht und kann ganz gewonnen werden. Das passt zu den Erkenntnissen meines eigenen Stücks zur Semantiküberlappung gegen Dichte.

Auf den ersten Blick mag dies nach “Just SEO mit unterschiedlicher Mathematik” klingen. Es ist nicht. Traditionelle SEO war in einer schwarzen Box immer Vermutungen. Wir hatten nie wirklich Zugang zu den Algorithmen in einem Format, das ihren Produktionsversionen nahe stand. Bei LLM -Systemen haben wir endlich etwas, auf dem uns die Suche nie wirklich gegeben hat: Zugang zu all den Forschungen, auf denen sie basieren. Die dichten Abrufpapiere, die Hybrid-Fusion-Methoden, die Wiederholungsmodelle, die alle öffentlich sind. Das bedeutet nicht, dass wir genau wissen, wie Chatgpt oder Gemini ihre Knöpfe wählt oder ihre Gewichte abstellten, aber es bedeutet, dass wir ein Modell skizzieren können, wie sie wahrscheinlich viel leichter arbeiten.

Von den Gewichten bis zur Sichtbarkeit

Was bedeutet das, wenn Sie die Maschine nicht bauen, sondern darin konkurrieren?

Überlappung bringt Sie in den Raum, die Dichte macht Sie glaubwürdig, lexikalisch hält Sie davon ab, herausgefiltert zu werden, und Klarheit macht Sie zum Gewinner.

Das ist die Logik des Antwortauswahlstapels.

Lexikalisches Abruf ist immer noch 40% des Kampfes. Wenn Ihr Inhalt nicht die Wörter enthält, die die Leute tatsächlich verwenden, betreten Sie nicht einmal den Pool.

Semantisches Abruf ist weitere 40%. Hier erfassen die Einbettungen eine Bedeutung. Ein Absatz, in dem Konzepte miteinander verbunden sind, karten besser als einer, der dünn und isoliert ist. Auf diese Weise wird Ihr Inhalt aufgegriffen, wenn Benutzer die Ausdrucksabfragen auf eine Weise, die Sie nicht erwartet haben, formuliert werden.

Neu rangieren ist 15%. Hier ist Klarheit und Struktur am wichtigsten. Passagen, die wie direkte Antworten aussehen, steigen. Passagen, die die Schlussfolgerung begraben.

Klarheit und Struktur sind der Tie-Breaker. 5% klingen vielleicht nicht nach viel, aber in engen Kämpfen entscheidet es, wer gewinnt.

Zwei Beispiele

Zapiers Hilfeinhalt

Zapiers Dokumentation ist bekanntlich sauber und beantwortet zuerst. Eine Frage wie “So verbinden Sie Google -Blätter mit Slack”Gibt eine ChatGPT -Antwort zurück, die mit den genauen Schritten beginnt, da der Inhalt von Zapier die genauen Daten liefert. Wenn Sie einen ChatGPT -Ressourcenlink durchklicken, ist die Seite, auf der Sie landen, kein Blog -Beitrag. Es ist wahrscheinlich nicht einmal ein Hilfeartikel. Es ist die tatsächliche Seite, auf der Sie die Aufgabe erfüllen können.

- Lexikalisch? Stark. Die Wörter “Google Sheets” und “Slack” sind genau dort.

- Semantisch? Stark. Die Passage Cluster verwandten Begriffe wie „Integration“, „Workflow“ und „Trigger“.

- Neu ranken? Stark. Die Schritte führen mit der Antwort.

- Klarheit? Sehr stark. Scannierbar, Antwort-First-Formatierung.

In einem System von 0,4 / 0,4 / 0,15 / 0,05 zeichnet sich Zapier in allen Zifferblättern auf. Aus diesem Grund werden ihre Inhalte oft in AI -Antworten angezeigt.

Ein Marketing -Blog -Beitrag

Vergleichen Sie dies mit einem typischen langen Marketing -Blog -Beitrag über „Teamproduktivitäts -Hacks“. Der Beitrag erwähnt Slack, Google Sheets und Integrationen, aber erst nach 700 Wörtern der Geschichte.

- Lexikalisch? Anwesend, aber begraben.

- Semantisch? Anständig, aber verstreut.

- Neu ranken? Schwach. Die Antwort auf “Wie verbinde ich Blätter mit Lack?” ist in einem Absatz auf halber Strecke versteckt.

- Klarheit? Schwach. Kein angehobener Answers-First-Chunk.

Obwohl der Inhalt das Thema technisch behandelt, kämpft er in diesem Gewichtungsmodell. Die Zapier -Passage gewinnt, weil sie darauf ausgerichtet ist, wie die Antwortauswahlschicht tatsächlich funktioniert.

Die traditionelle Suche führt den Benutzer weiterhin, um zu lesen, zu bewerten und zu entscheiden, ob die Seite, auf die er landet, deren Bedürfnisse beantwortet. KI -Antworten sind unterschiedlich. Sie bitten Sie nicht, Ergebnisse zu analysieren. Sie zeichnen Ihre Absicht direkt auf die Aufgabe oder die Antwort ab und verschieben Sie direkt in den Modus “Get It Done”. Sie fragen: “So verbinden Sie Google -Blätter mit Slack,„Und am Ende haben Sie eine Liste von Schritten oder einen Link zu der Seite, auf der die Arbeiten abgeschlossen sind. Sie erhalten keinen Blog -Beitrag, in dem erklärt wird, wie jemand dies während seiner Mittagspause gemacht hat, und es dauerte nur fünf Minuten.

Volatilität über Plattformen hinweg

Es gibt einen weiteren großen Unterschied zu traditioneller SEO. Suchmaschinen konvergierten trotz Algorithmusveränderungen im Laufe der Zeit. Stellen Sie Google und Bing dieselbe Frage, und Sie werden häufig ähnliche Ergebnisse sehen.

LLM -Plattformen konvergieren nicht oder zumindest nicht so weit. Stellen Sie die gleiche Frage in Verwirrung, Gemini und Chatgpt, und Sie erhalten oft drei verschiedene Antworten. Diese Volatilität spiegelt wider, wie jedes System seine Zifferblätter gewichtet. Gemini kann Zitate betonen. Verwirrung kann die Breite des Abrufs belohnen. Chatgpt kann aggressiv für den Konversationsstil komprimieren. Und wir haben Daten, die zeigen, dass zwischen einer traditionellen Engine und einer LLM-antwortenden Antwortplattform eine breite Kluft zwischen den Antworten gibt. BrightEdge’s Daten (62% Meinungsverschiedenheiten über Markenempfehlungen) und tiefgreifende Daten (… KI -Module und Antwortmotoren unterscheiden sich dramatisch von Suchmaschinen, wobei nur 8 – 12% der Ergebnisse überlappen) Präsentieren Sie dies klar.

Für SEOs bedeutet dies, dass Optimierung nicht mehr einsgroß ist. Ihr Inhalt kann in einem System gut und in einem anderen schlecht abschneiden. Diese Fragmentierung ist neu, und Sie müssen Wege finden, um sie als Verbraucherverhalten in der Verwendung dieser Plattformen für Antworten verschieben zu können.

Warum ist das wichtig

Im alten Modell verwischten Hunderte von Ranking -Faktoren zu einem Konsens „Best Mühe“. In dem neuen Modell ist es, als hätten Sie es mit vier großen Zifferblättern zu tun, und jede Plattform stellt sie anders ab. Fairerweise ist die Komplexität hinter diesen Zifferblättern immer noch ziemlich groß.

Ignorieren Sie lexikalische Überlappungen und Sie verlieren einen Teil dieser 40% der Stimmen. Schreiben Sie semantisch dünner Inhalt, und Sie können weitere 40 verlieren. Ramble oder begraben Ihre Antwort, und Sie werden nicht wieder auftreten. Pad mit Flusen und Sie vermissen den Klarheitschub.

Der Messerkampf findet nicht mehr auf einem Seich. Es passiert in der Antwortauswahlpipeline. Und es ist sehr unwahrscheinlich, dass diese Zifferblätter statisch sind. Sie können wetten, dass sie sich in Bezug auf viele andere Faktoren bewegen, einschließlich der relativen Positionierung des anderen.

Die nächste Schicht: Überprüfung

Heute ist die Antwortauswahl das letzte Tor vor der Generation. Aber die nächste Stufe ist bereits in Sicht: Überprüfung.

Untersuchungen zeigen, wie Modelle sich selbst kritisieren und die Fakten erhöhen können. Selbstschneidung demonstriert Abruf-, Generations- und Kritikschleifen. SelfCheckgpt führt Konsistenzprüfungen über mehrere Generationen hinweg durch. OpenAI soll einen universellen Prüf für GPT-5 bauen. Und ich habe über dieses ganze Thema in einem kürzlich durchgeführten Substack -Artikel geschrieben.

Wenn die Überprüfungsschichten reifen, bringt Sie die Abrufbarkeit nur in den Raum. Die Überprüfung entscheidet, ob Sie dort bleiben.

Schließen

Das ist wirklich nicht regelmäßig SEO in Verkleidung. Es ist eine Verschiebung. Wir können jetzt deutlicher sehen, wie sich die Zahnräder drehen, weil mehr von der Forschung öffentlich ist. Wir sehen auch Volatilität, da jede Plattform diese Zahnräder unterschiedlich dreht.

Für Seos denke ich, dass der Imbiss klar ist. Halten Sie die lexikalische Überlappung stark. Bauen Sie die semantische Dichte in Cluster auf. Mit der Antwort führen. Machen Sie Passagen prägnant und hebensfähig. Und ich verstehe, wie sehr das nach traditioneller SEO -Führung klingt. Ich verstehe auch, wie sich die Plattformen, die die Informationen verwenden, so stark von regulären Suchmaschinen unterscheiden. Diese Unterschiede sind wichtig.

So überleben Sie den Messerkampf in AI. Und bald, wie Sie den Test des Verifizierers bestehen, sobald Sie dort sind.

Weitere Ressourcen:

- AI -Suche ändert alles – ist Ihre Organisation für den Wettbewerb aufgebaut?

- Warum generative KI SEO nicht tötet – es schafft neue Möglichkeiten

- SEO im Zeitalter der KI

Dieser Beitrag wurde ursprünglich auf Duane Forrester Decodes veröffentlicht.

Ausgewähltes Bild: Tete_escape/Shutterstock