SEOzempic: Qualität vor Quantität bei der Google-Indizierung

Bildnachweis: Lyna ™

Bildnachweis: Lyna ™Zwei Trends haben sich auf die Art und Weise ausgewirkt, wie Google Indexe erstellt. Während das offene Web geschrumpft ist, muss Google große Content-Plattformen wie YouTube, Reddit und TikTok durchsuchen, die oft auf „komplexen“ JS-Frameworks basieren, um neue Inhalte zu finden. Gleichzeitig verändert die KI die zugrunde liegende Dynamik des Webs, indem sie mittelmäßige und schlechte Inhalte überflüssig macht.

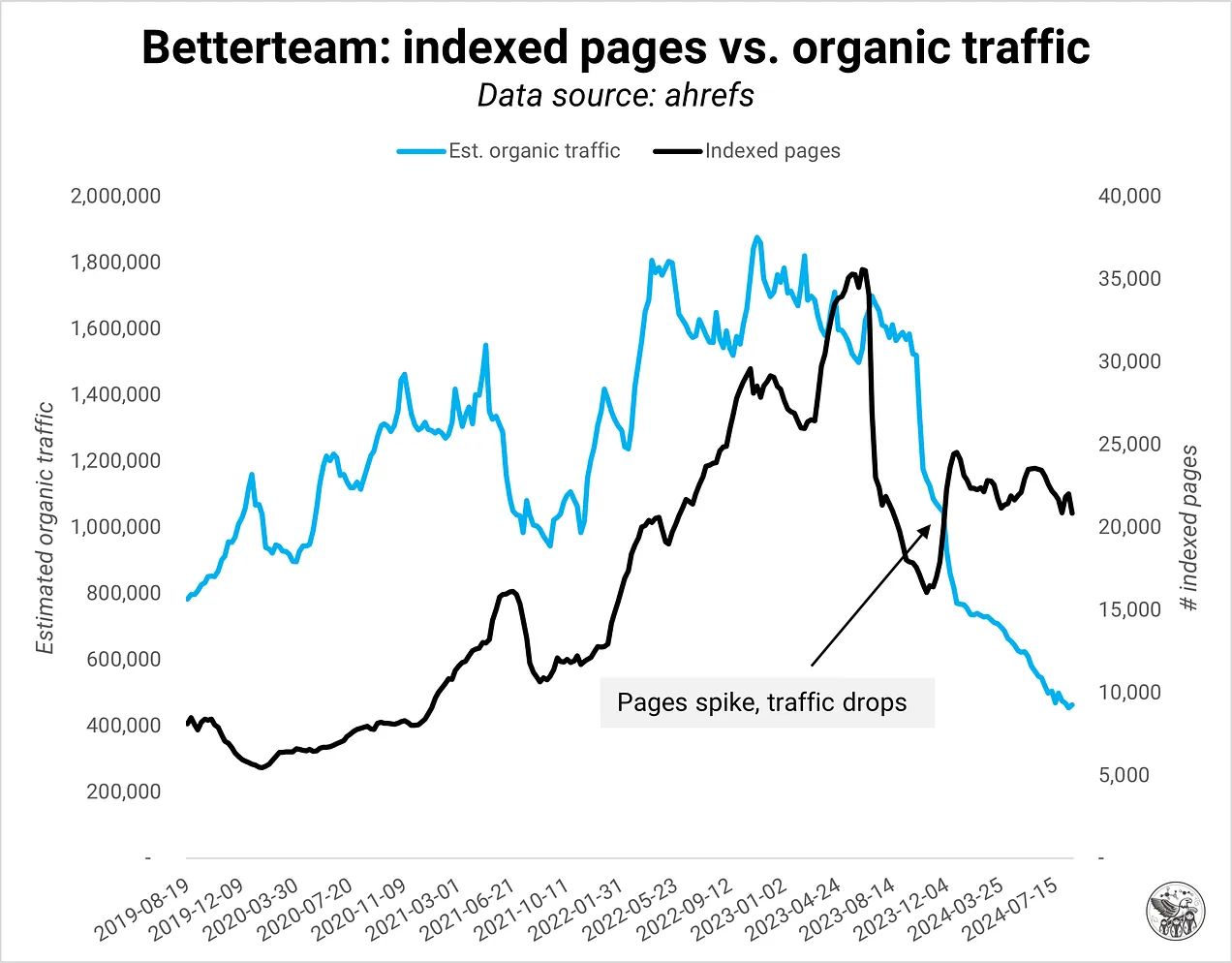

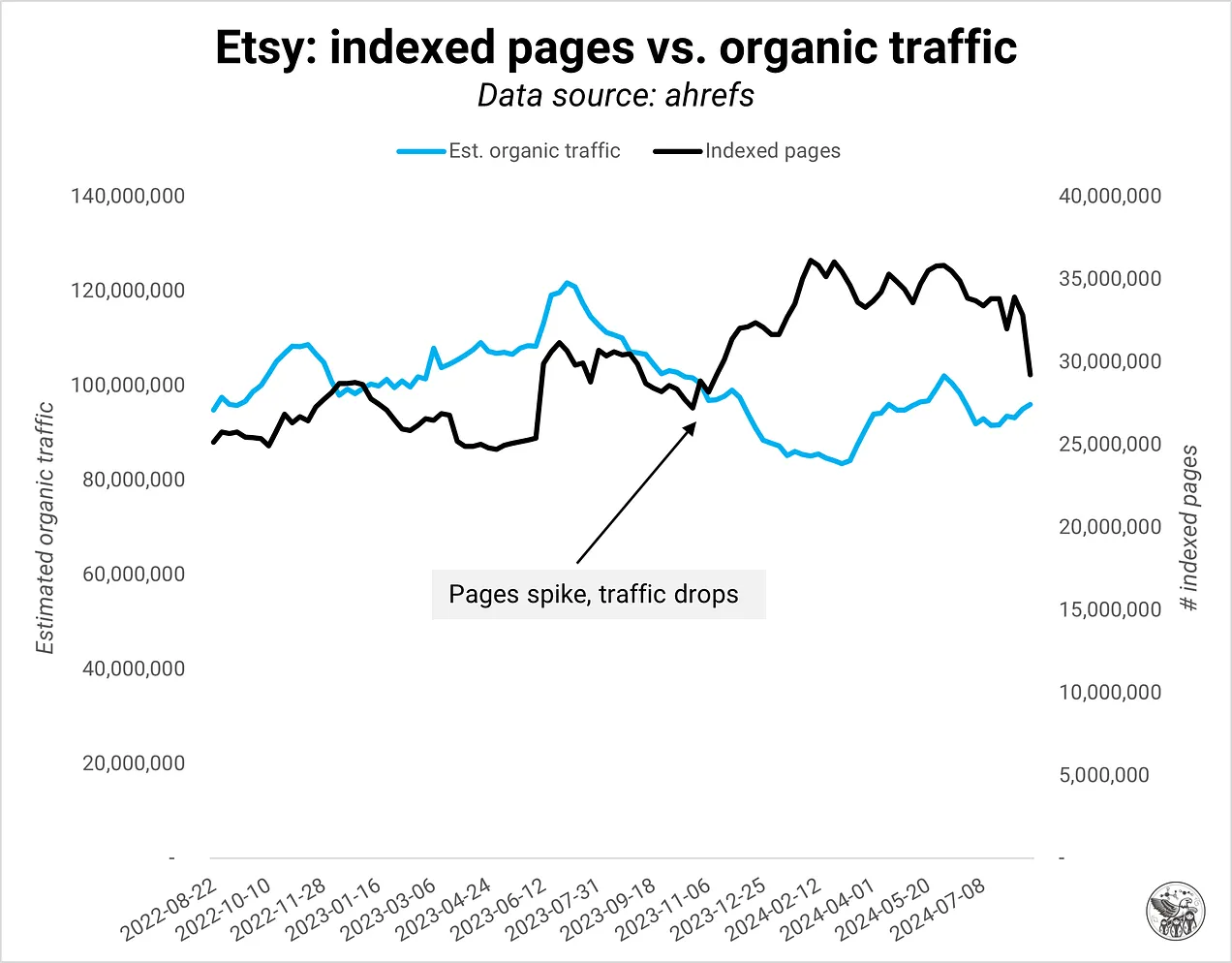

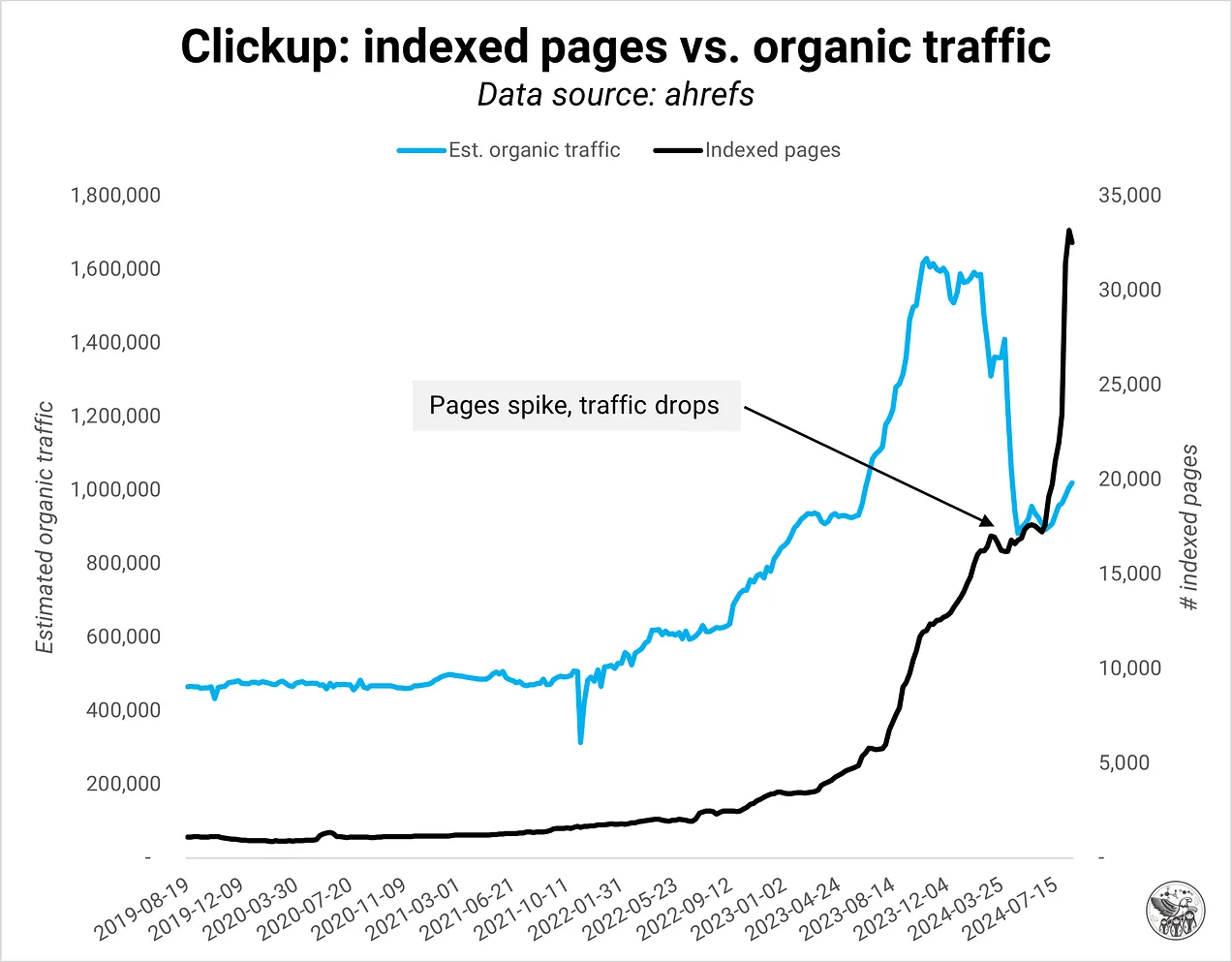

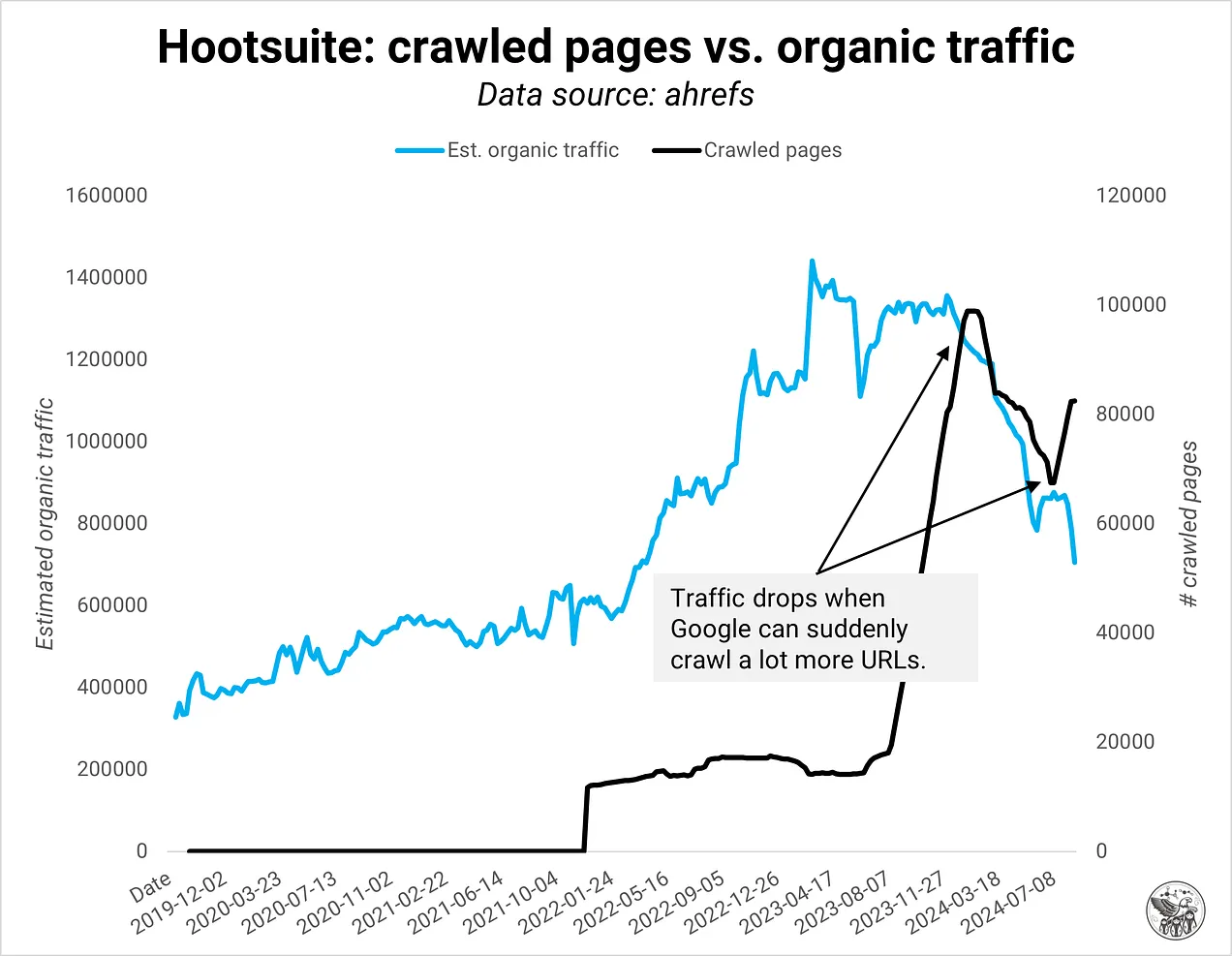

Bei meiner Arbeit mit einigen der größten Websites im Internet ist mir in letzter Zeit eine umgekehrte Beziehung zwischen indexierten Seiten und organischem Traffic aufgefallen. Mehr Seiten sind nicht automatisch schlecht, erfüllen aber oft nicht die Qualitätserwartungen von Google. Oder besser gesagt: Die Definition von Qualität hat sich geändert. Für SEOs steht viel auf dem Spiel: Wenn Sie zu aggressiv expandieren, kann Ihre gesamte Domain darunter leiden. Wir müssen unsere Einstellung zur Qualität ändern und Überwachungssysteme entwickeln, die uns helfen, die Domainqualität auf Seitenebene zu verstehen.

Gesättigt

Google hat die Behandlung von Domains ab etwa Oktober 2023 geändert: Kein Beispiel zeigte vor Oktober die umgekehrte Beziehung. Außerdem hatte Google Indexierungsprobleme, als es das Core-Algorithmus-Update im Oktober 2023 veröffentlichte, genau wie es jetzt beim Update vom August 2024 passierte.

Vor der Änderung indexierte Google alles und priorisierte den qualitativ hochwertigsten Inhalt einer Domain. Man kann es sich wie Goldwaschen vorstellen, bei dem man eine Pfanne mit Kies, Erde und Wasser füllt und dann schwenkt und rührt, bis nur noch wertvolles Material übrig bleibt.

Nun müssen sich eine Domain und ihr Inhalt beweisen, bevor Google überhaupt versucht, nach Gold zu schürfen. Wenn die Domain zu viele minderwertige Inhalte hat, indexiert Google möglicherweise nur einige Seiten oder in Extremfällen überhaupt keine.

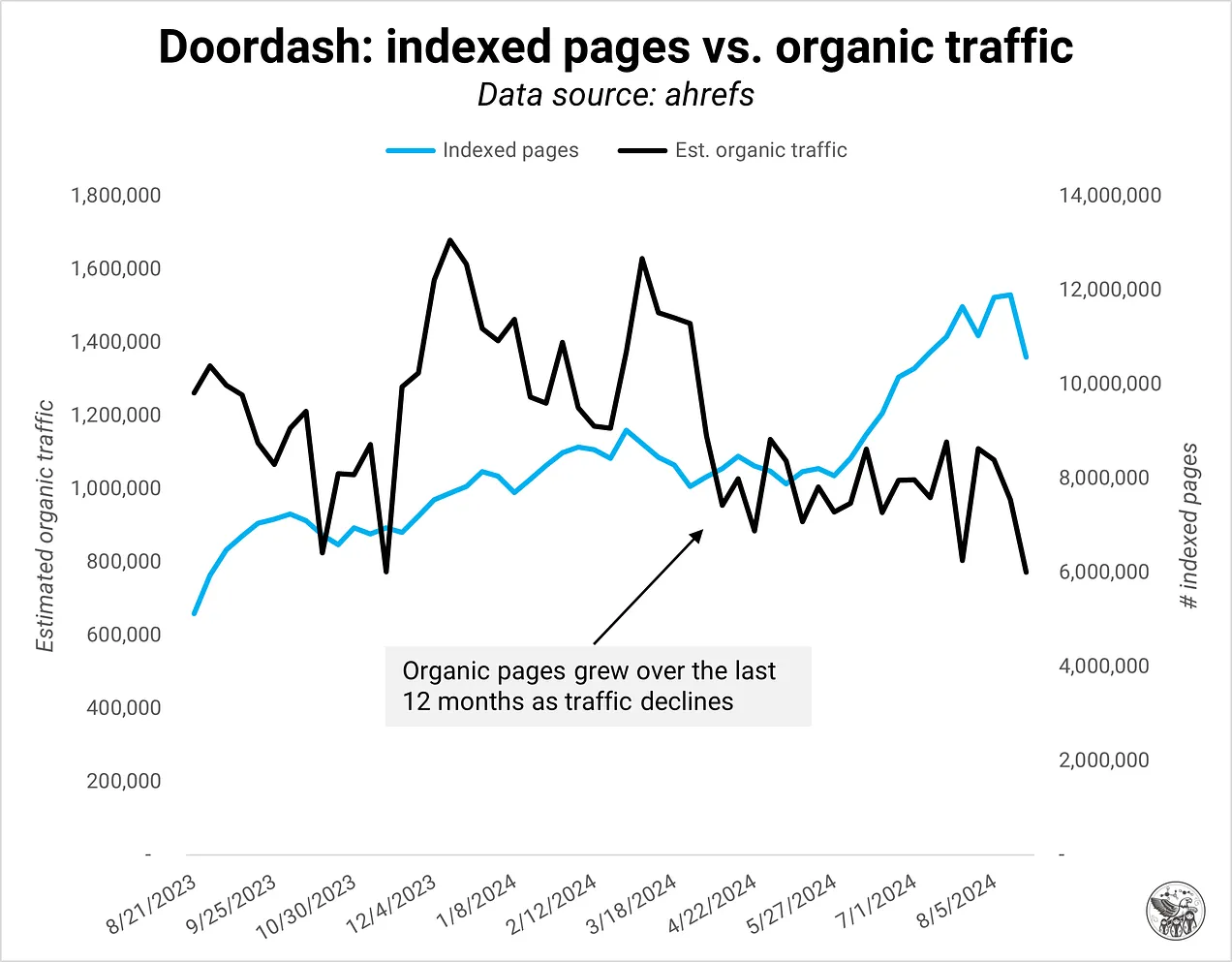

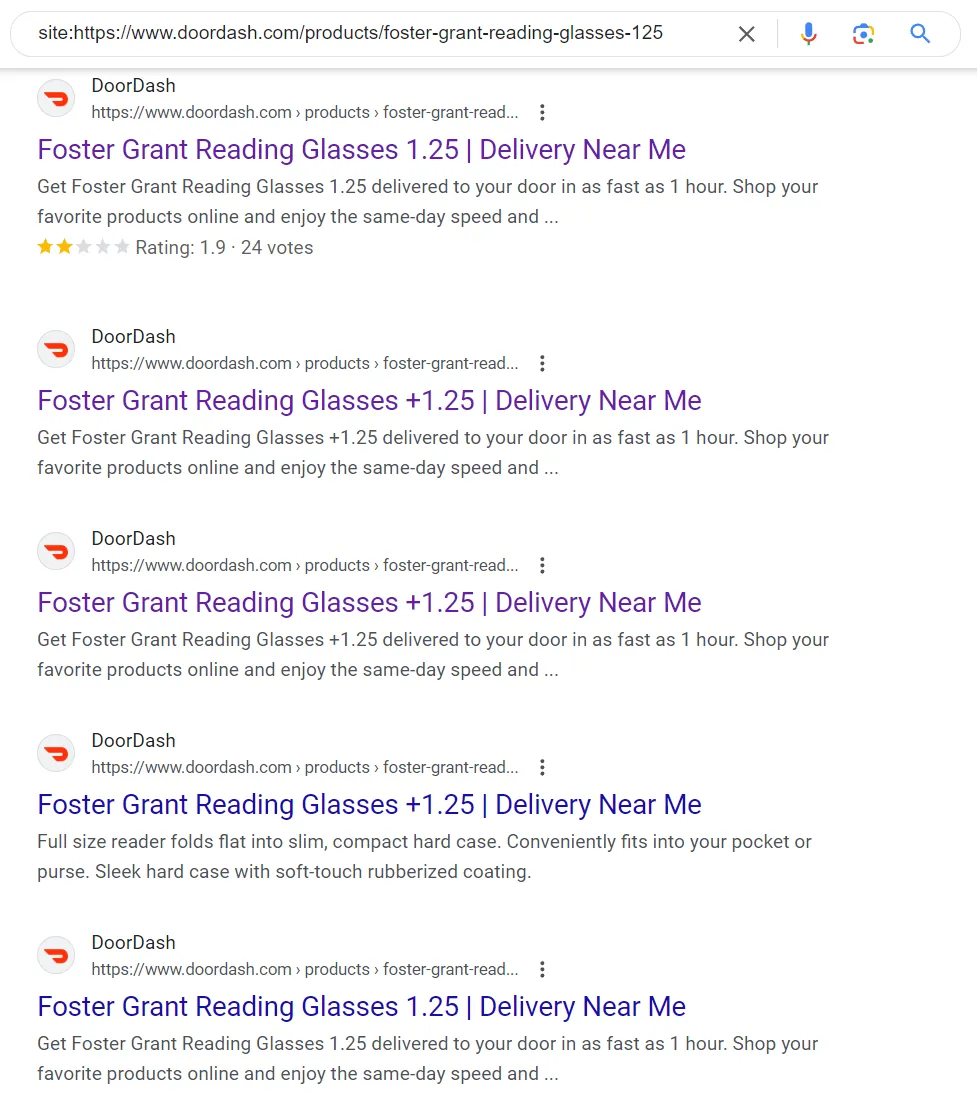

Ein Beispiel ist doordash.com, das in den letzten 12 Monaten viele Seiten hinzugefügt hat und dabei organischen Traffic verloren hat. Zumindest einige, vielleicht alle, der neuen Seiten entsprachen nicht den Qualitätserwartungen von Google.

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigAber warum? Was hat sich geändert? Ich schließe daraus:

- Google möchte Ressourcen und Kosten einsparen und strebt im Zuge der Umstellung auf betriebliche Effizienz eine stärkere Steigerung der Effizienz an.

- Die partielle Indexierung ist effektiver gegen minderwertige Inhalte und Spam. Anstatt neue Seiten einer Domain zu indexieren und dann zu versuchen, sie zu ranken, beobachtet Google die Gesamtqualität einer Domain und begegnet neuen Seiten mit entsprechender Skepsis.

- Wenn eine Domain wiederholt Inhalte von geringer Qualität produziert, hat sie keine Chance, den Index von Google weiter zu verschmutzen.

- Google hat seine Qualitätsansprüche höher gelegt, weil es im Web so viel mehr Inhalte gibt, aber auch, um seinen Index für RAG (Grundlage für KI-Übersichten) und Trainingsmodelle zu optimieren.

Diese Betonung der Domänenqualität als Signal bedeutet, dass Sie die Art und Weise ändern müssen, wie Sie Ihre Website überwachen, um die Qualität zu berücksichtigen. Mein Leitsatz: „Wenn Sie dem Web nichts Neues oder Besseres hinzufügen können, ist es wahrscheinlich nicht gut genug.“

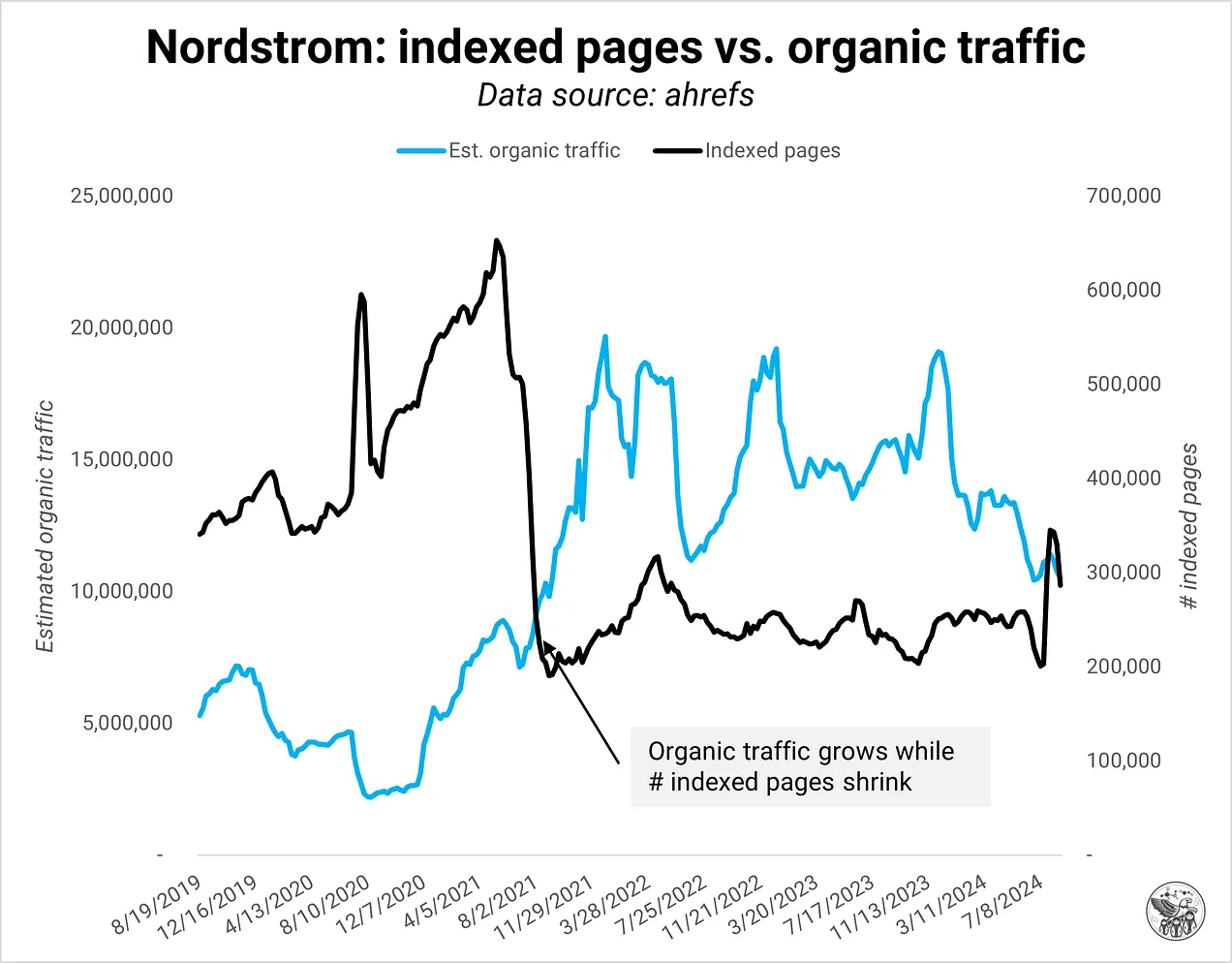

Hochwertiges Essen

Mit Domänenqualität beschreibe ich das Verhältnis von indexierten Seiten, die Googles Qualitätsstandard erfüllen, zu denen, die dies nicht tun. Beachten Sie, dass nur indexierte Seiten für die Qualität zählen. Der maximale Prozentsatz „schlechter“ Seiten, bevor Google den Verkehr zu einer Domäne reduziert, ist unklar, aber wir können sicherlich erkennen, wann dieser Prozentsatz erreicht wird:

Bildnachweis: Kevin Indig

Bildnachweis: Kevin Indig Bildnachweis: Kevin Indig

Bildnachweis: Kevin Indig Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigIch definiere Domainqualität als ein Signal, das sich aus 3 Bereichen zusammensetzt: Benutzererfahrung, Inhaltsqualität und technischer Zustand:

- Benutzererfahrung: Finden Benutzer, wonach sie suchen?

- Inhaltsqualität: Informationsgewinn, inhaltliche Gestaltung, Vollständigkeit

- Technisch optimiert: Duplicate Content, Rendering, Onpage Content für Kontext, „gecrawlt, nicht indexiert/entdeckt“weiche 404-Fehler

Ein Beispiel für doppelten Inhalt (Bildnachweis: Kevin Indig)

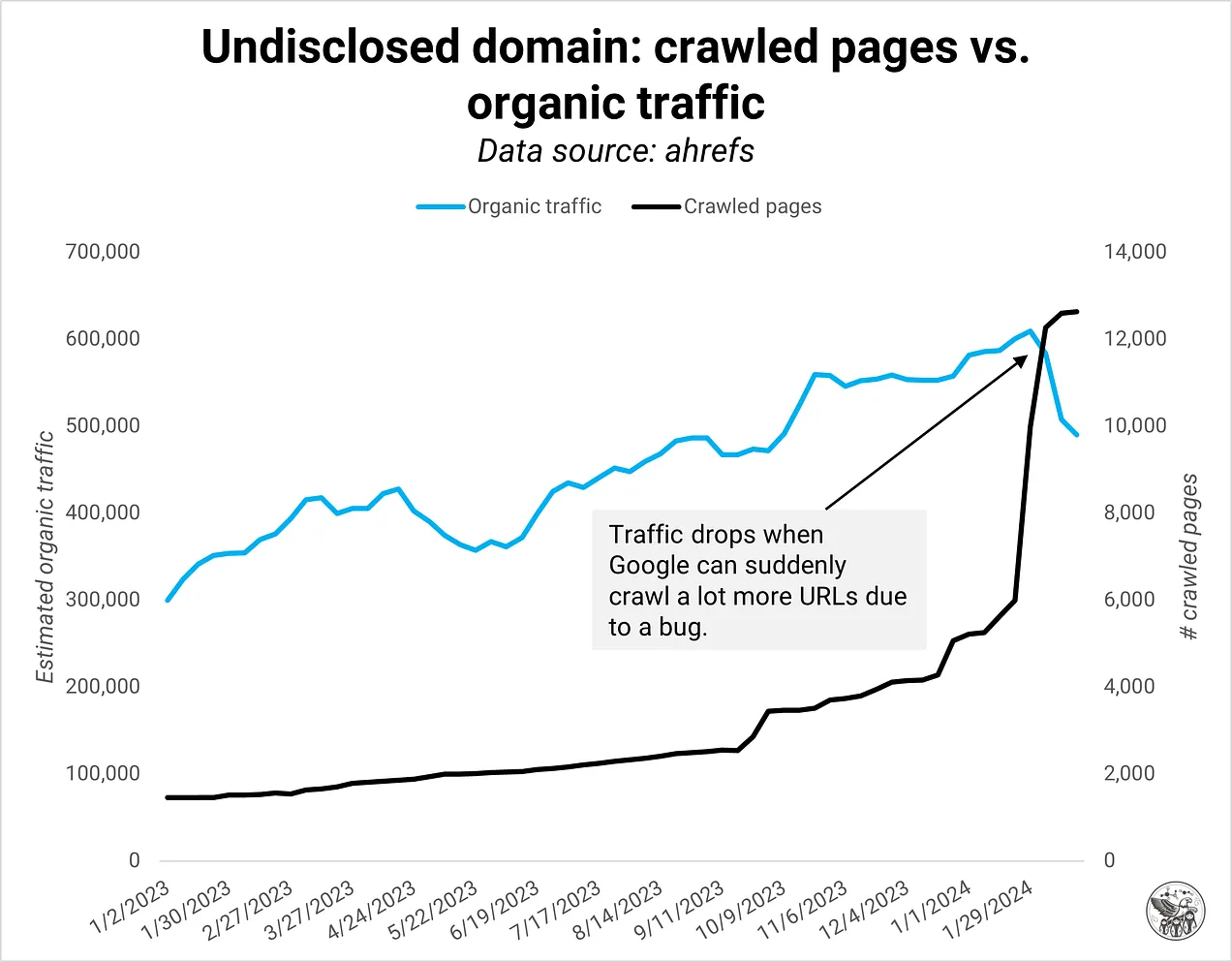

Ein Beispiel für doppelten Inhalt (Bildnachweis: Kevin Indig)Ein plötzlicher Anstieg der indexierten Seiten deutet normalerweise auf ein technisches Problem hin, wie z. B. doppelte Inhalte aus Parametern, Internationalisierung oder fehlerhafte Seitennummerierungen. Im folgenden Beispiel reduzierte Google den organischen Verkehr zu dieser Domain sofort, als eine Seitennummerierungslogik nicht mehr funktionierte, was zu vielen doppelten Inhalten führte. Ich habe noch nie erlebt, dass Google so schnell auf technische Fehler reagiert, aber das ist der neue Stand der SEO, in dem wir uns befinden.

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigIn anderen Fällen deutet ein Anstieg der indexierten Seiten auf eine programmatische SEO-Strategie hin, bei der die Domain viele Seiten mit derselben Vorlage gestartet hat. Wenn die Qualität der Inhalte auf programmatischen Seiten nicht gut genug ist, dreht Google den Traffic-Hahn schnell zu.

Bildnachweis: Kevin Indig

Bildnachweis: Kevin Indig Bildnachweis: Kevin Indig

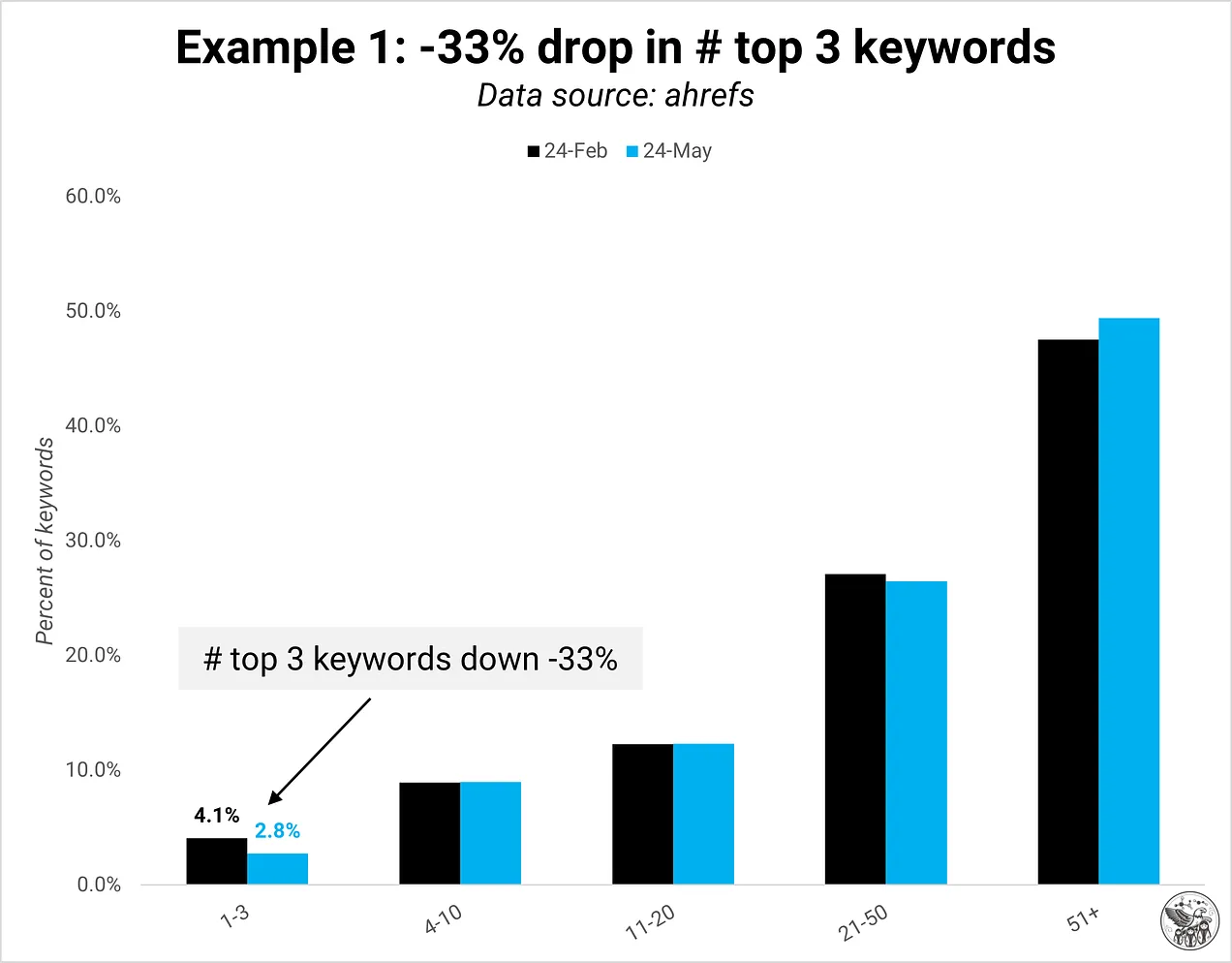

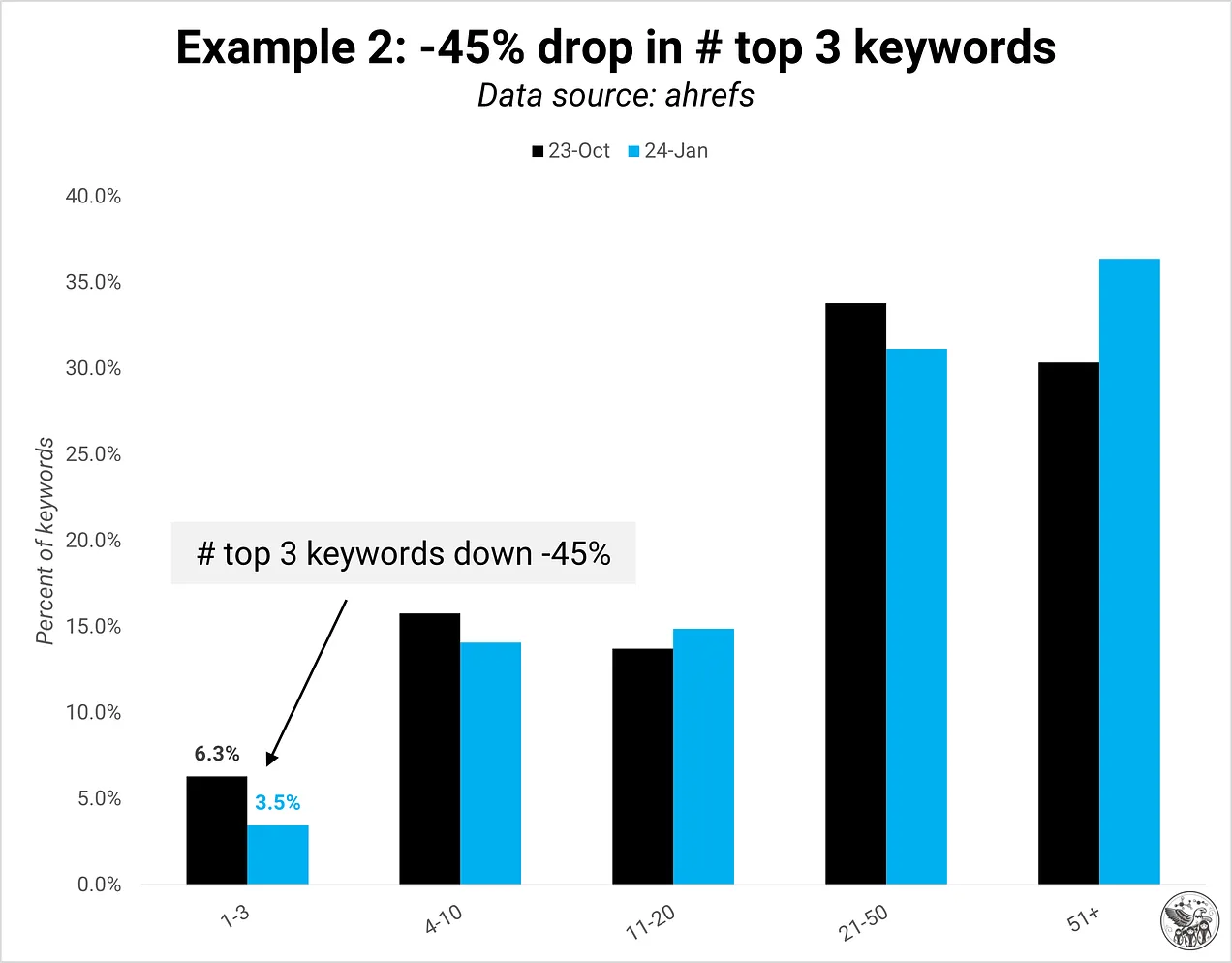

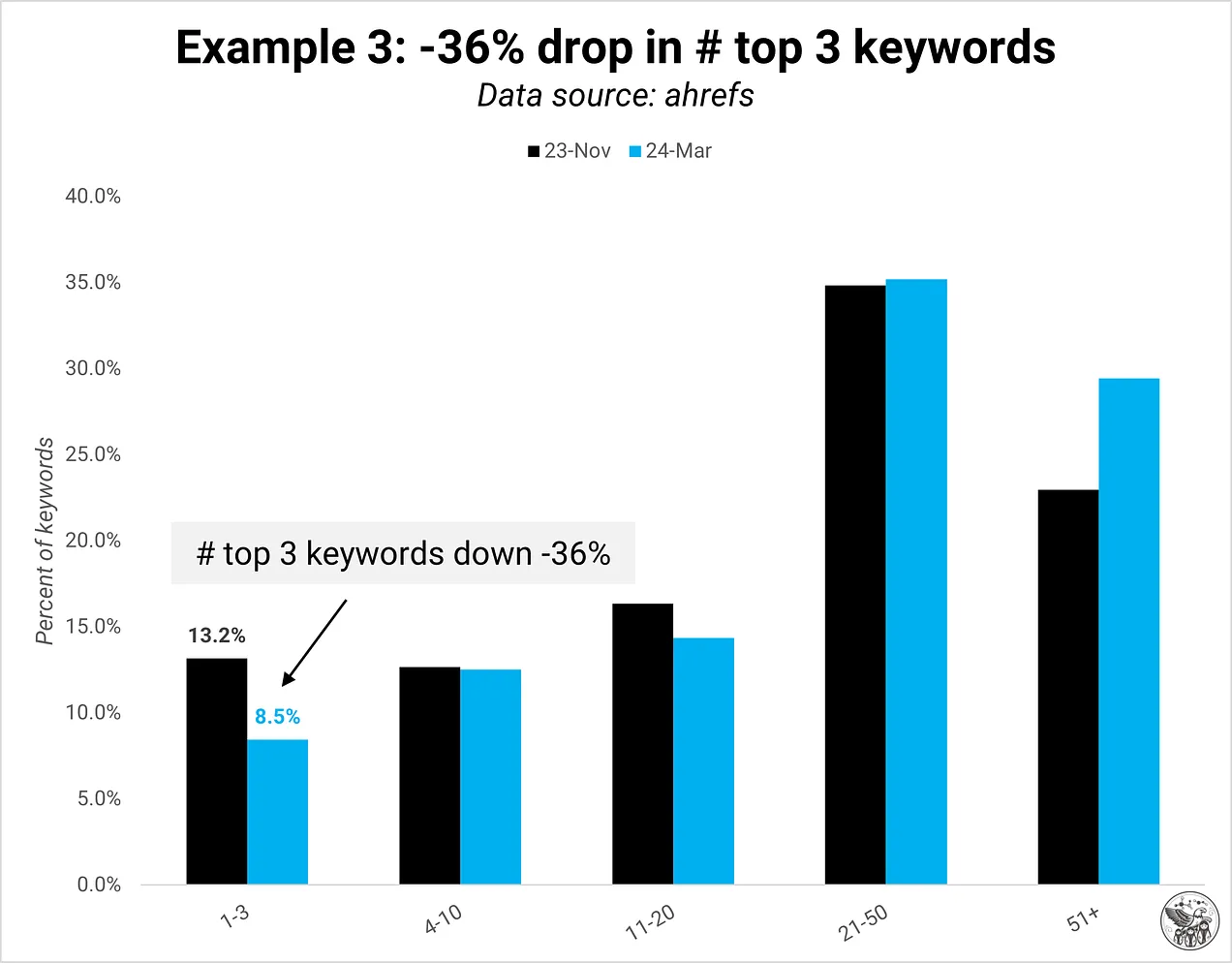

Bildnachweis: Kevin IndigAls Reaktion darauf reduziert Google häufig die Anzahl der Keywords, die in den ersten drei Positionen rangieren. Die Anzahl der Keywords, die in anderen Positionen rangieren, bleibt häufig relativ stabil.

Bildnachweis: Kevin Indig

Bildnachweis: Kevin Indig Bildnachweis: Kevin Indig

Bildnachweis: Kevin Indig Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigDie Größe vergrößert das Problem: Die Domänenqualität kann bei größeren Sites ein größeres Problem darstellen, obwohl auch kleinere Sites betroffen sein können.

Das Hinzufügen neuer Seiten zu Ihrer Domain ist nicht per se schlecht. Sie sollten dabei nur vorsichtig sein. Beispielsweise kann die Veröffentlichung neuer Thought Leadership- oder Produktmarketing-Inhalte, die nicht direkt auf ein Keyword abzielen, für Site-Besucher dennoch sehr wertvoll sein. Deshalb ist es wichtig, neben SEO-Kennzahlen auch das Engagement und die Benutzerzufriedenheit zu messen.

Diätplan

Der wichtigste Weg, „fette“ Seiten (mit geringer Qualität) fernzuhalten und das Risiko zu verringern, von einem Core-Update betroffen zu sein, besteht darin, das richtige Überwachungssystem zu implementieren. Es ist schwierig, etwas zu verbessern, das man nicht misst.

Im Herzen eines Domänenqualitätsüberwachungssystem ist ein Dashboard, das Kennzahlen für jede Seite verfolgt und sie mit dem Durchschnitt vergleicht. Wenn ich nur drei Kennzahlen auswählen könnte, würde ich die inverse Absprungrate, Konvertierungen (weich und hart) und Klicks Rangfolge nach Seitentyp pro Seite mit dem Durchschnitt vergleichen. Im Idealfall benachrichtigt Sie Ihr System, wenn es zu einem Anstieg der Crawling-Rate kommt, insbesondere bei neuen Seiten, die zuvor nicht gecrawlt wurden.

In „So messen die besten Unternehmen die Qualität von Inhalten“ schreibe ich:

1/ Messen Sie für die Produktionsqualität Kennzahlen wie den SEO-Editor-Score, den Flesch-/Lesbarkeits-Score oder die Anzahl der Rechtschreib-/Grammatikfehler.

2/ Messen Sie für die Leistungsqualität Kennzahlen wie Anzahl der Top-3-Platzierungen, Verhältnis von Verweildauer auf der Seite zu geschätzter Lesezeit, inverse Absprungrate, Scrolltiefe oder Pipeline-Wert.

3/ Messen Sie zur Erhaltung der Qualität die Leistungskennzahlen im Zeitverlauf und im Jahresvergleich.

Ignorieren Sie bei der Überwachung Ihrer Site Seiten wie „Servicebedingungen“ oder „Über uns“, da deren Funktion nichts mit SEO zu tun hat.

Verstärkungsphase

Die Überwachung ist der erste Schritt zum Verständnis der Domänenqualität Ihrer Site. Sie müssen nicht immer weitere Seiten hinzufügen, um zu wachsen. Oft können Sie Ihren vorhandenen Seitenbestand verbessern, aber Sie benötigen zunächst ein Überwachungssystem, um dies herauszufinden.

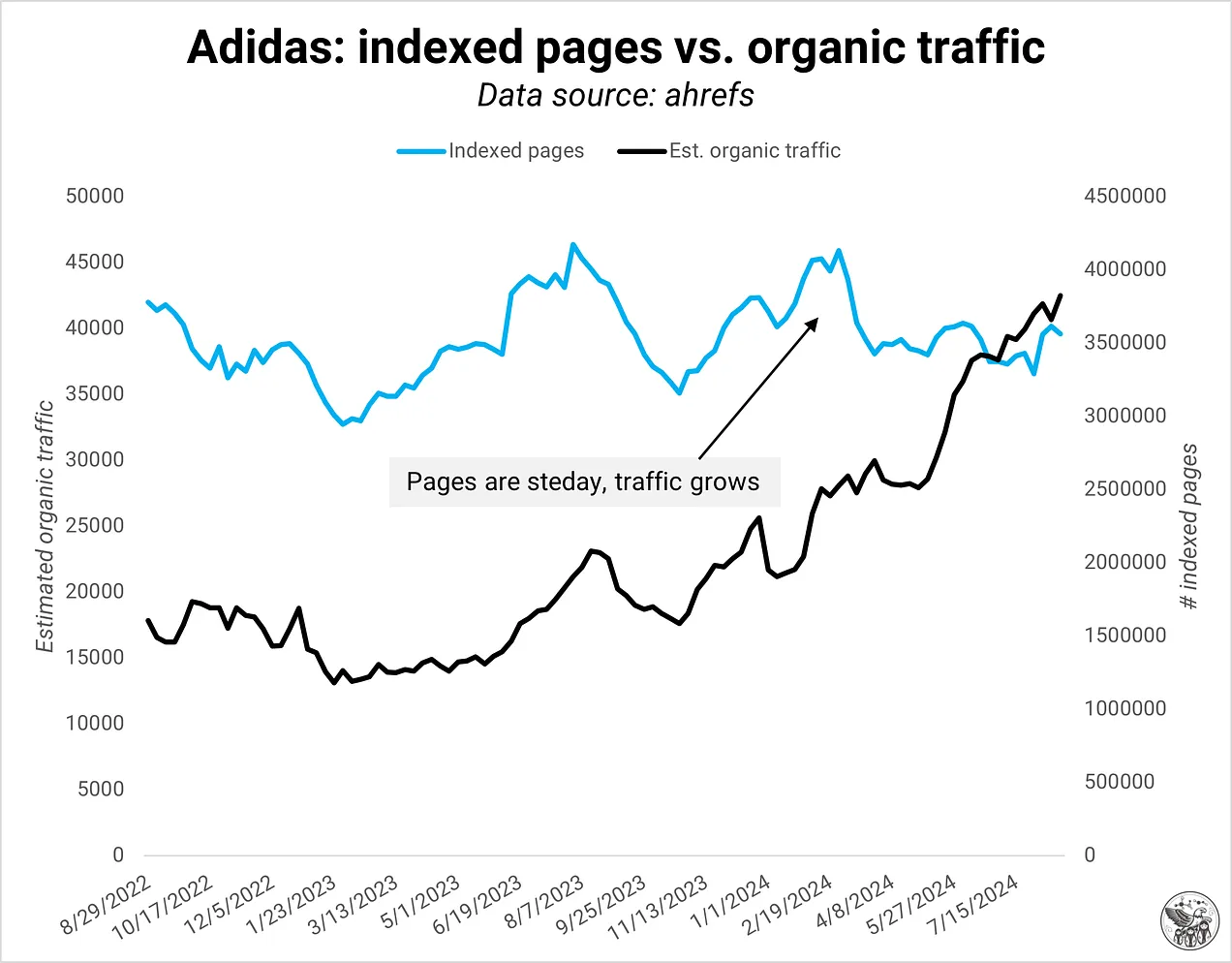

Adidas ist ein gutes Beispiel für eine Domain, die den organischen Verkehr allein durch die Optimierung ihrer vorhandenen Seiten steigern konnte.

Bildnachweis: Kevin Indig

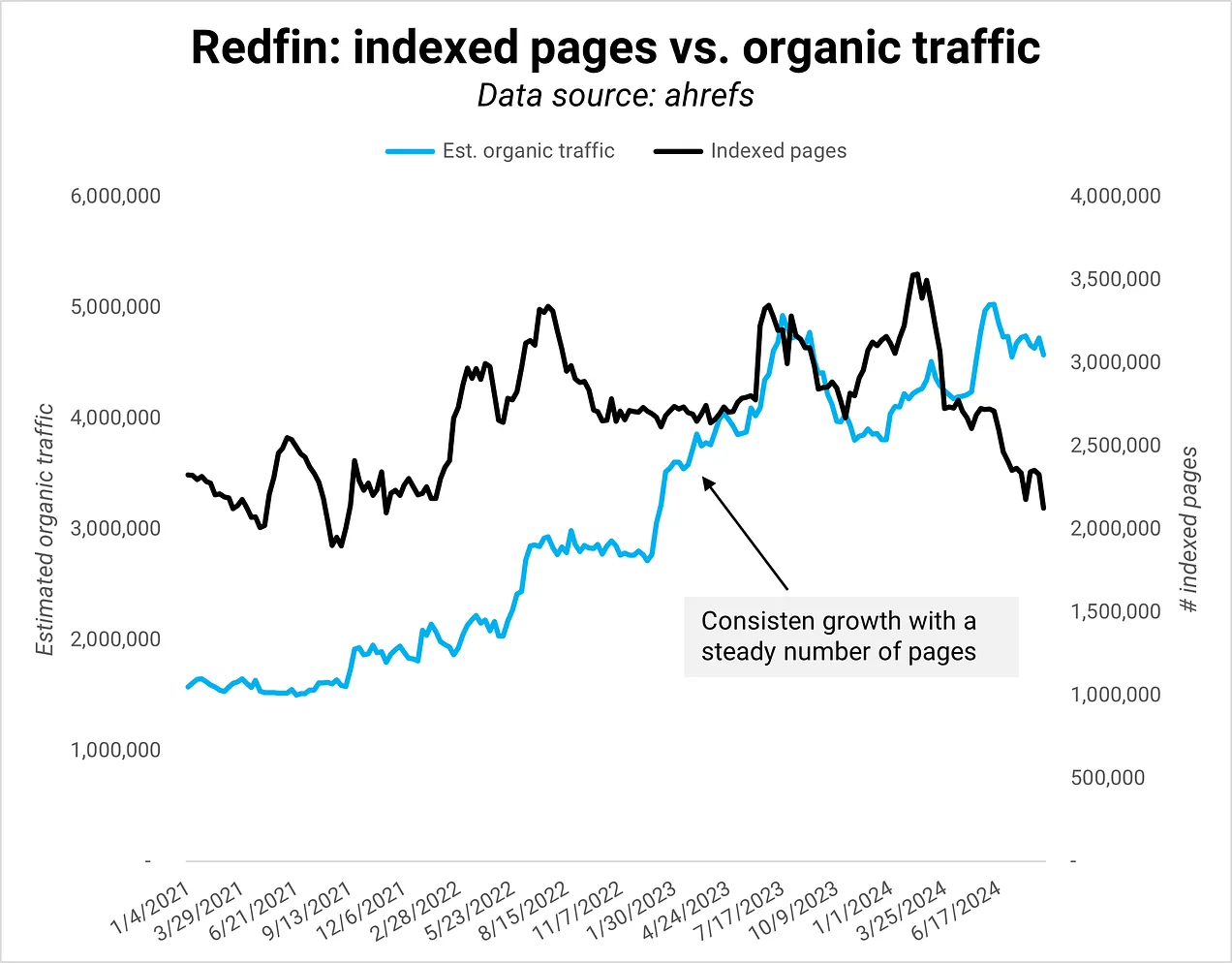

Bildnachweis: Kevin IndigEin weiteres Beispiel ist Redfin, das eine konstante Seitenzahl beibehielt und gleichzeitig den organischen Verkehr deutlich steigerte.

Bildnachweis: Kevin Indig

Bildnachweis: Kevin IndigZitat von Snr. Director of Product Growth in meinem Redfin Deep Dive zum Erreichen der richtigen Qualitätsansprüche:

Wir bringen unsere lokale Expertise auf die Website – wir sind die Autorität auf dem Immobilienmarkt, beantworten Fragen zum Leben in einer Gegend und bieten ein komplettes Angebot an Immobilien zum Verkauf und zur Miete in den gesamten Vereinigten Staaten.

Aufrechterhaltung technischer Spitzenleistung – unsere Site ist groß (über 100 Mio. Seiten), daher können wir Dinge wie Leistung, Crawling-Gesundheit und Datenqualität nicht vernachlässigen. Manchmal können die am wenigsten „reizvollen“ Bemühungen die wirkungsvollsten sein.“

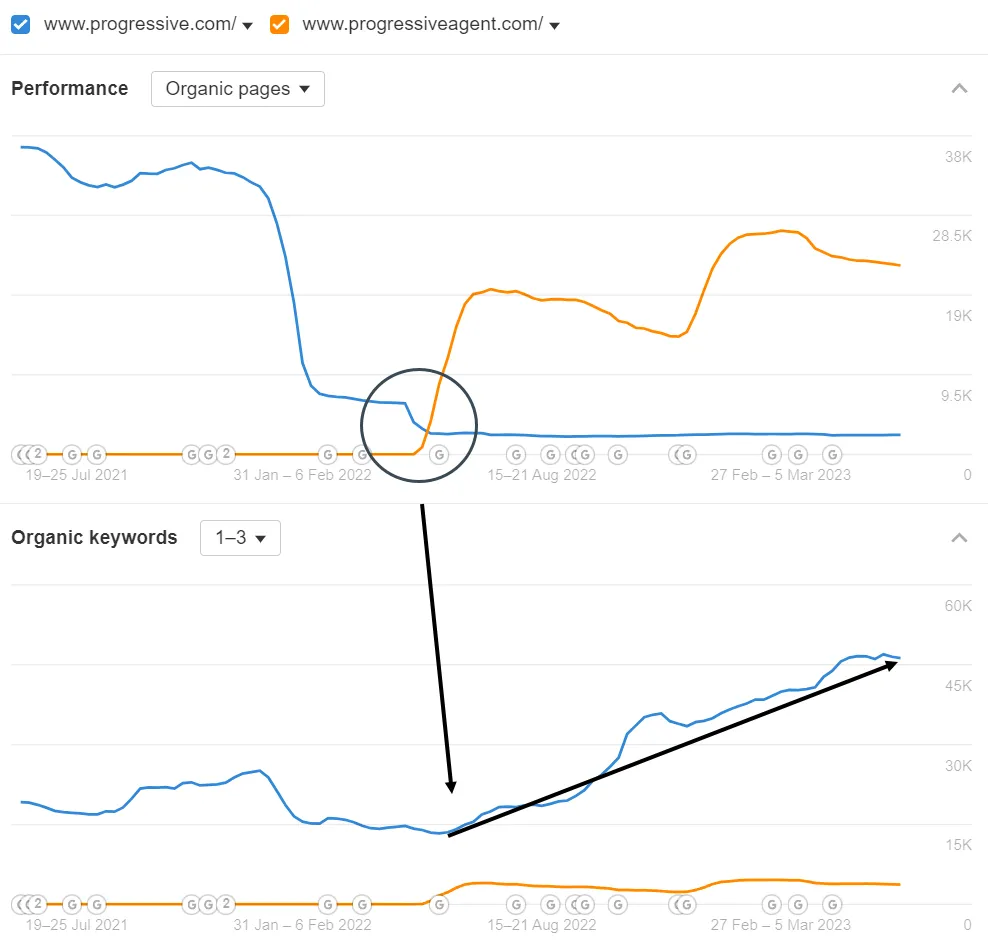

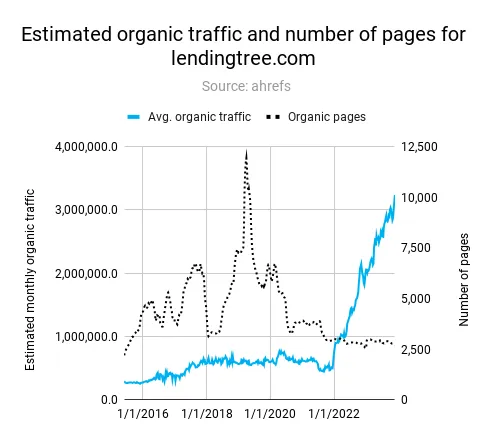

Unternehmen wie Lending Tree oder Progressive konnten durch die Reduzierung der Anzahl von Seiten, die ihren Qualitätsstandards nicht entsprachen, erhebliche Erfolge erzielen (siehe Screenshots der Deep Dives unten).

Progressive hat Agentenseiten auf eine separate Domäne verschoben, um die Qualität seiner Hauptdomäne zu verbessern. (Bildnachweis: Kevin Indig)

Progressive hat Agentenseiten auf eine separate Domäne verschoben, um die Qualität seiner Hauptdomäne zu verbessern. (Bildnachweis: Kevin Indig) LendingTree hat viele Seiten mit geringer Qualität gelöscht, um das organische Traffic-Wachstum anzukurbeln. (Bildnachweis: Kevin Indig)

LendingTree hat viele Seiten mit geringer Qualität gelöscht, um das organische Traffic-Wachstum anzukurbeln. (Bildnachweis: Kevin Indig)Abschluss

Google belohnt Websites, die fit bleiben. Im Jahr 2020 schrieb ich darüber, dass der Index von Google möglicherweise kleiner ist, als wir denken. Die Indexgröße war früher schon früh ein Ziel. Aber heute geht es weniger darum, so viele Seiten wie möglich zu indexieren, sondern vielmehr darum, die richtigen Seiten zu haben. Die Definition von „gut“ hat sich weiterentwickelt. Google ist wählerischer, wen es in den Club aufnimmt.

Im selben Artikel habe ich die Hypothese aufgestellt, dass Google zu einer Indexierungs-API wechseln und die Verantwortung für die Indexierung den Websitebesitzern überlassen würde. Das ist bisher nicht eingetreten, aber man könnte sagen, dass Google mehr APIs für die Indexierung verwendet:

- Die 60-Dollar-Jahresvereinbarung zwischen Google und Reddit deckt ein Zehntel der Suchergebnisse von Google ab (vorausgesetzt, Reddit ist für fast jedes Schlüsselwort in den Top 10 vertreten).

- Im E-Commerce, wo mehr organische Einträge weiter oben in den Suchergebnissen erscheinen, verlässt sich Google stärker auf den Produkt-Feed im Merchant Center, um neue Produkte zu indizieren und seinen Shopping Graph zu pflegen.

- SERP-Funktionen wie Top Stories, die in der Nachrichtenbranche von entscheidender Bedeutung sind, sind kleine Dienste mit eigener Indexierungslogik.

Mit Blick auf die Zukunft stellt sich die große Frage, wie sich die Indizierung verändern wird, wenn mehr Benutzer über KI-Übersichten und KI-Chatbots suchen. Vorausgesetzt, LLMs müssen weiterhin in der Lage sein, Seiten zu rendern, bleibt technische SEO-Arbeit unerlässlich – die Motivation für die Indizierung ändert sich jedoch von der Bereitstellung von Webergebnissen hin zu Trainingsmodellen. Infolgedessen wird der Wert von Seiten, die nichts Neues zu bieten haben, noch näher bei Null liegen als heute.