So laufen Sie Deepseek und andere LLMs lokal auf Ihrem Mac

Chatgpt, Googles Gemini und Apple Intelligence sind leistungsstark, aber alle teilen einen großen Nachteil – sie benötigen ständigen Zugriff auf das Internet, um zu arbeiten. Wenn Sie die Privatsphäre schätzen und eine bessere Leistung wünschen, ist es eine gute Alternative, ein großes Sprachmodell wie Deepseek, Googles Gemma oder das Lama von Google, Lama von META vor Ort auszuführen.

Denken Sie, dass es kompliziert klingt? Es ist einfacher als du denkst. Mit den richtigen Werkzeugen können Sie Deepseek oder andere beliebte LLM vor Ort auf Ihrem Mac mit minimalem Aufwand ausführen.

Warum Deepseek oder andere LLMs vor Ort auf Ihrem Mac laufen lassen?

Privatsphäre und Sicherheit sind die größten Gründe für die lokale Ausführung eines LLM. Dadurch wird sichergestellt, dass das Modell Daten nicht mit externen Servern teilen kann, wodurch Sie die vollständige Kontrolle bei der Arbeit mit privaten und vertraulichen Informationen erhalten.

Es ist auch schneller und billiger, KI -Modelle lokal auszuführen, um wiederkehrende API -Gebühren zu vermeiden. Wenn Sie ein LLM lokal ausführen, können Sie es mit proprietären Daten trainieren und seine Antworten auf bessere Anforderungen anpassen. Dieser Ansatz spart auf lange Sicht auch kostbare Zeit, wenn Sie Deepseek oder andere LLMs für Arbeitszwecke verwenden möchten.

Wenn Sie Entwickler sind, möchten Sie möglicherweise LLMs lokal ausführen und mit ihnen herumspielen, um zu sehen, wie sie Ihrer Arbeit helfen können. Mit dem erforderlichen technischen Know-how können Sie auch die verfügbaren KI-Modelle verwenden, um Agenten-Tools für Ihre Arbeit zu erstellen.

So laufen Sie LLMs wie Deepseek und Lama vor Ort auf Ihrem Mac

Sie könnten denken, dass das Ausführen von LLMs lokal auf einen High-End-Mac mit viel RAM zugreifen muss. Aber das ist nicht der Fall. Es ist möglich, ein LLM lokal auszuführen, wenn Sie einen von Apple Silicon betriebenen Mac mit mindestens 16 GB Systemspeicher haben. Selbst 8 GB Speicher funktioniert, aber Ihre Systemleistung wird negativ beeinflusst.

Beachten Sie, dass LLMs in verschiedenen Variationen und mit unterschiedlichen Parametern verfügbar sind. Je höher der Parameter ist, desto komplexer und schlauer ist das LLM. Dies bedeutet auch, dass das KI -Modell mehr Platz und Ressourcen benötigt, um auszuführen. Zum Beispiel ist das Lama von Meta in verschiedenen Variationen erhältlich, darunter einen mit einem Parameter von 70 Milliarden. Um dieses Modell auszuführen, müssen Sie einen Mac mit mehr als 40 GB freiem Speicher und mehr als 48 GB Systemspeicher verwenden.

Versuchen Sie im Idealfall, einen LLM wie Deepseek mit einem Parameter von 7 oder 8 Milliarden zu betreiben. Das sollte reibungslos lokal auf einem Mac mit 16 GB Systemspeicher laufen. Wenn Sie Zugriff auf einen leistungsstärkeren Mac haben, verwenden Sie ein Modell, das Ihren Anforderungen entspricht.

Es ist wichtig, das richtige Modell abhängig von Ihrem Anwendungsfall herunterzuladen. Einige LLMs können gut argumentieren, während andere gut in der Lösung von Codierungsanfragen können. Einige werden besser bei STEM -Chats und Aufgaben arbeiten, während andere in Multiturn -Gesprächen und einer langen Kontextkohärenz gut sind.

LM Studio ist der einfachste Weg, um LLMs lokal auf Ihrem Mac auszuführen

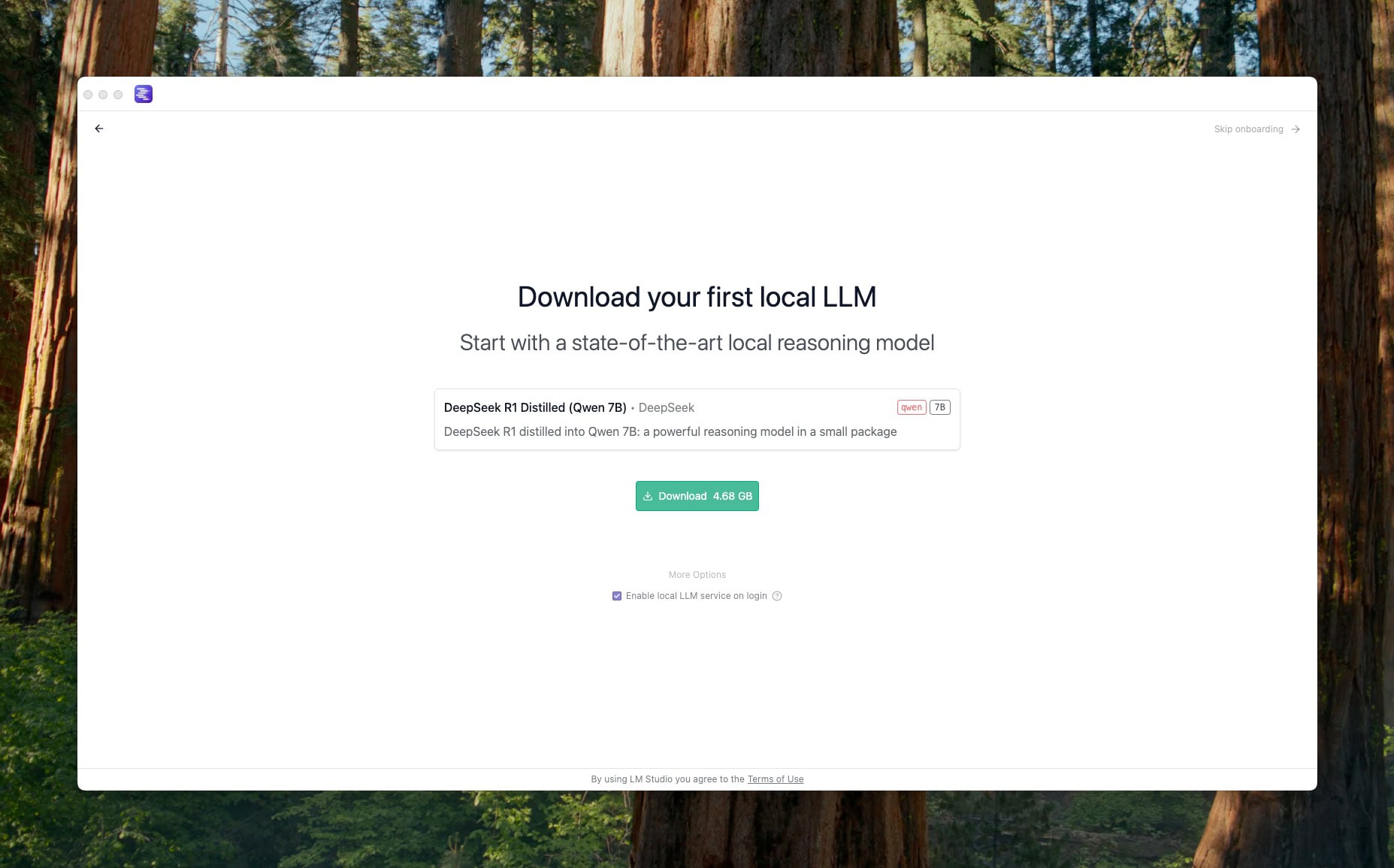

Screenshot: Rajesh Pandey/Cultofmac

Wenn Sie LLMs wie Deepseek und Lama vor Ort auf Ihrem Mac ausführen möchten, ist das LM Studio der einfachste Weg, um loszulegen. Die Software ist kostenlos für den persönlichen Gebrauch.

Hier erfahren Sie, wie man anfängt:

- Laden Sie LM Studio auf Ihrem Mac herunter und installieren Sie sie und starten Sie die Anwendung.

- Wenn Ihr Hauptziel darin besteht, Deepseek lokal zu betreiben, führen Sie den Onboarding -Prozess ab und laden Sie das Modell herunter. Andernfalls können Sie den Onboarding -Schritt überspringen.

- Sie sollten a sehen Suchleiste An der Spitze im LM Studio bittet Sie dazu Wählen Sie ein zum Laden eines Modells aus. Klicken Sie darauf und suchen Sie nach dem LLM, den Sie herunterladen und installieren möchten.

- Alternativ gehen Sie die Liste der verfügbaren LLMs durch, indem Sie auf das klicken Einstellungen Zahnrad in der unteren rechten Ecke des LM Studio. Wählen Sie aus dem Fenster, das sich öffnet, die aus Modellsuche Tab von links. Öffnen Sie dieses Fenster alternativ direkt mit der Tastaturverknüpfung des Befehls M -Tastatur m.

- Sie sehen alle hier aufgeführten KI -Modelle zum Download zur Verfügung. Das Fenster rechts liefert einen Einblick in ein bestimmtes Modell und liefert eine kurze Beschreibung und seine Token -Grenze.

- Wählen Sie Deepseek, Lama von Meta, Qwen, Phi-4 oder eine der anderen verfügbaren LLMs aus. Klicken Sie dann auf die Herunterladen Taste unten rechts

- Hinweis: Während Sie mehrere LLMs herunterladen können, kann LM Studio nur ein Modell laden und ausführen.

Verwenden Sie Ihr heruntergeladenes LLM

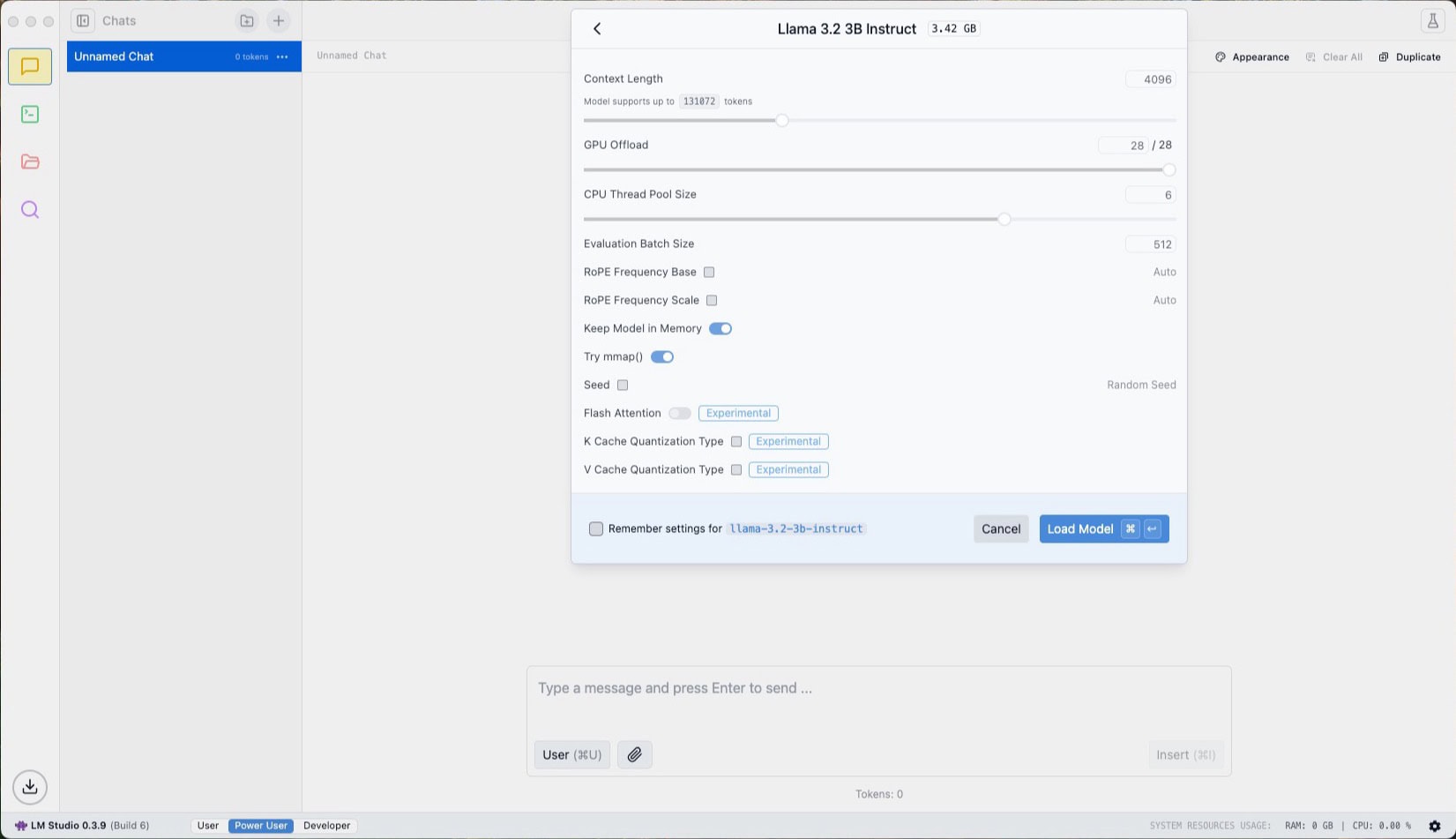

Screenshot: Rajesh Pandey/Cultofmac

Nach Ihrem LLM -Download -Abschluss schließen Sie das Mission Control -Fenster von LM Studio. Klicken Sie dann auf die obere Suchleiste und laden Sie die kürzlich heruntergeladene LLM. Mit LM Studio können Sie beim Laden eines KI -Modells die Kontextlänge, die CPU -Thread -Poolgröße und andere Schlüsseleinstellungen konfigurieren. Sie können diese Einstellungen so lassen, wie sie sind, wenn Sie sich nicht sicher sind, was sie tun.

Sie können jetzt Fragen stellen oder das LLM verwenden, wie Sie möchten.

Mit LM Studio können Sie mehrere separate Chats mit einem LLM haben. Um eine neue Konversation zu initiieren, klicken Sie auf das Symbol von der Symbolleiste oben. Dies ist eine praktische Option, wenn Sie gleichzeitig das LLM verwenden, um an mehreren Projekten zu arbeiten. Sie können auch Ordner erstellen und Ihre Chats darin sortieren.

So verhindern Sie, dass Sie alle Ressourcen Ihres Mac verwenden

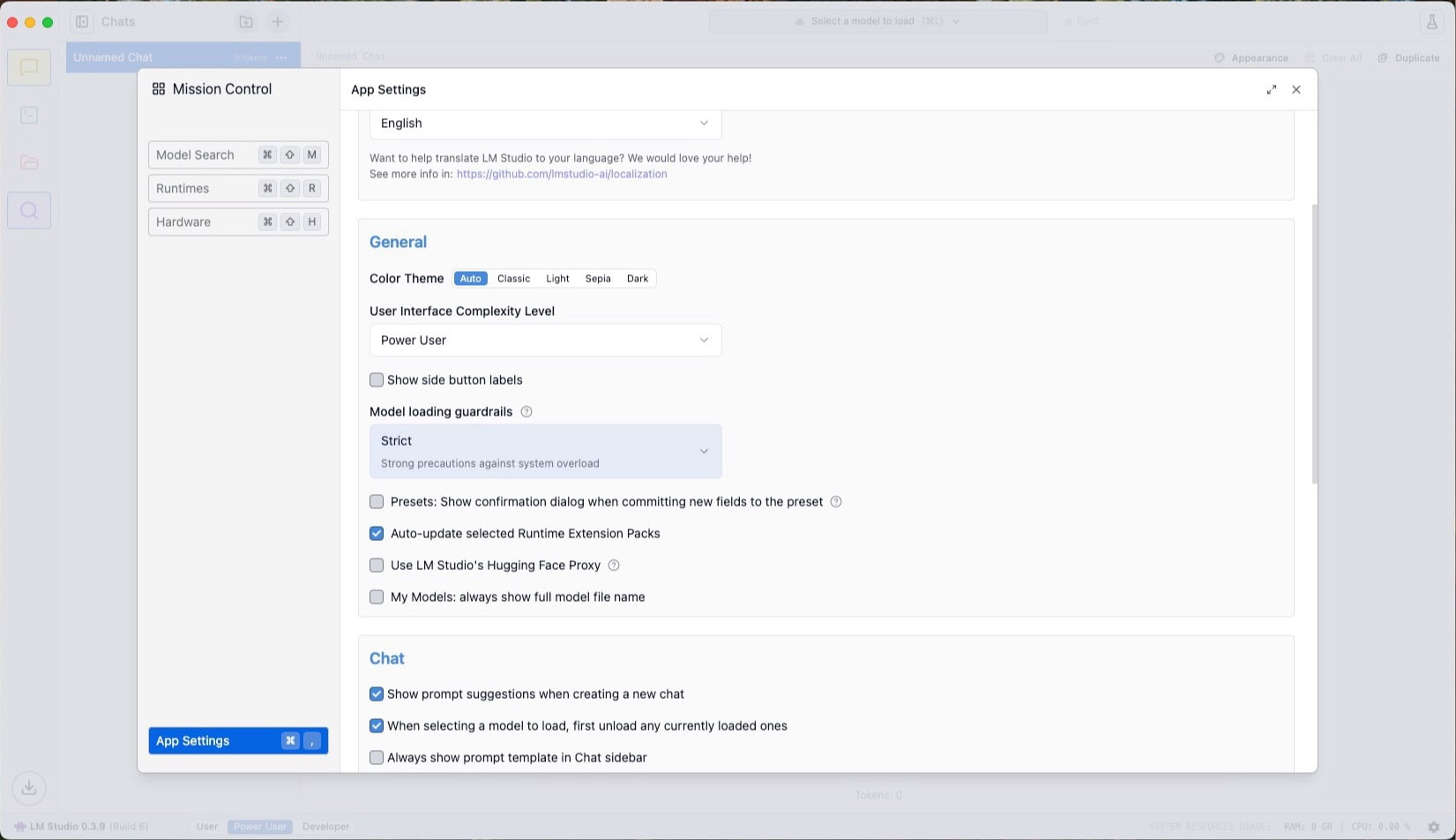

Screenshot: Rajesh Pandey/Cultofmac

Wenn Sie sich Sorgen über das KI -Modell machen, das alle Systemressourcen Ihres Mac auffressen Befehl ,. Dann stellen Sie die Modellladen -Ladung Die Einstellung ist streng eingestellt. Dies sollte sicherstellen, dass der LLM Ihren Mac nicht überlastet.

Sie können die Ressourcennutzung von LM Studio und Ihrem heruntergeladenen LLM in der unteren Symbolleiste sehen. Wenn die CPU- oder Speicherverwendung zu hoch ist, sollten Sie zu einem KI -Modell mit einem niedrigeren Parameter umstellen, um die Ressourcenverbrauch zu verringern.

In den letzten Wochen habe ich LM Studio verwendet, um Lama und Deepseek LLMs lokal auf meinem Mac zu betreiben, und ich war beeindruckt von der Leistung meines M1 Mac Mini mit 16 GB RAM. Es hat die Arbeitsbelastung mühelos behandelt. Ja, die LLMs laufen reibungsloser auf meinem M1 Pro MacBook Pro. Und die Leistung sollte bei neueren M2-, M3- oder M4-Macs mit höherem Systemspeicher noch besser sein.

Selbst wenn Sie einen älteren Apple Silicon Mac besitzen, gehen Sie nicht davon aus, dass er nicht reibungslos ausführen kann. Sie werden von seiner Leistung überrascht sein.

Stellen Sie sicher, dass Sie unerwünschte LLMs von Ihrem Mac löschen, um Platz freizugeben. Andernfalls, wenn Sie einige davon herunterladen, um es auszuprobieren, haben Sie in kürzester Zeit keinen Platz mehr.