Suchen Sie mit Ihrer Kamera mithilfe von Visual Intelligence auf dem iPhone 16 nach Informationen

Die neue Visual Intelligence-Funktion in iOS 18.2 bietet eine schnelle Möglichkeit, Informationen zu finden, indem man einfach die Kamera des iPhone 16 auf ein Objekt in der realen Welt richtet. Dann können Sie ChatGPT bitten, zu erklären, was Sie gerade sehen, eine umgekehrte Bildersuche durchführen, um Produkte zu finden und Dinge visuell nachzuschlagen, Informationen über ein Unternehmen zu erhalten, während Sie die Straße entlanggehen, und schnell Ereignisse zu Ihrem Kalender hinzufügen.

So funktioniert es.

So nutzen Sie Visual Intelligence auf dem iPhone 16

Während Visual Intelligence stark auf Drittanbieter wie ChatGPT und Google angewiesen ist, ist es durch die Integration in das iPhone 16 ein leistungsstarkes Tool für den täglichen Gebrauch. Mit dem neuen KI-Tool von Apple stehen Ihnen diese unglaublich nützlichen Informationsquellen direkt zur Verfügung.

Sie benötigen jedoch die richtige Kombination aus Hardware und Software. Apple hat Visual Intelligence exklusiv für iPhone 16-Besitzer entwickelt, da die KI-Funktion die neue Kamerasteuerungstaste verwendet, die nur auf diesen Telefonen verfügbar ist. Und wie bereits erwähnt, müssen Sie iOS 18.2 oder höher ausführen.

Inhaltsverzeichnis: So nutzen Sie Visual Intelligence auf dem iPhone 16

- Installieren Sie iOS 18.2 und aktivieren Sie Apple Intelligence

- Klicken und halten Sie die Kamerasteuerung

- Schauen Sie nach, indem Sie ein Foto machen

- Weitere intelligente kontextabhängige Funktionen

- Wie funktioniert visuelle Intelligenz?

- Weitere Apple Intelligence-Funktionen

Installieren Sie iOS 18.2 und aktivieren Sie Apple Intelligence

Die ersten Apple Intelligence-Funktionen wurden in iOS 18.1 verfügbar. Visuelle Intelligenz ist Teil davon zweite Runde der KI-Funktionen von Apple, derzeit im Betatest in iOS 18.2. Sie können (und sollten!) die öffentliche Betaversion von iOS 18.2 installieren, indem Sie auf gehen Einstellungen > Allgemein > Software-Update > Beta-Updates. Gehen Sie nach dem Update zu Einstellungen > Apple Intelligence & Siri um Apple Intelligence zu aktivieren.

Klicken und halten Sie die Kamerasteuerung

Sie starten Visual Intelligence, indem Sie auf die Kamerasteuerung klicken und diese gedrückt halten. Dabei handelt es sich um eine Geste, die das Klicken und Halten der Seitentaste zum Aktivieren von Siri nachahmt. Da die Kamerasteuerung nur auf dem iPhone 16 verfügbar ist, ist die Funktion nur auf diesen Telefonen verfügbar. Apple könnte wahrscheinlich eine Control Center-Taste aktivieren, um die Funktion auf iPhone 15 Pro-Modellen zu nutzen, hat sich jedoch nicht dafür entschieden, dies zu aktivieren.

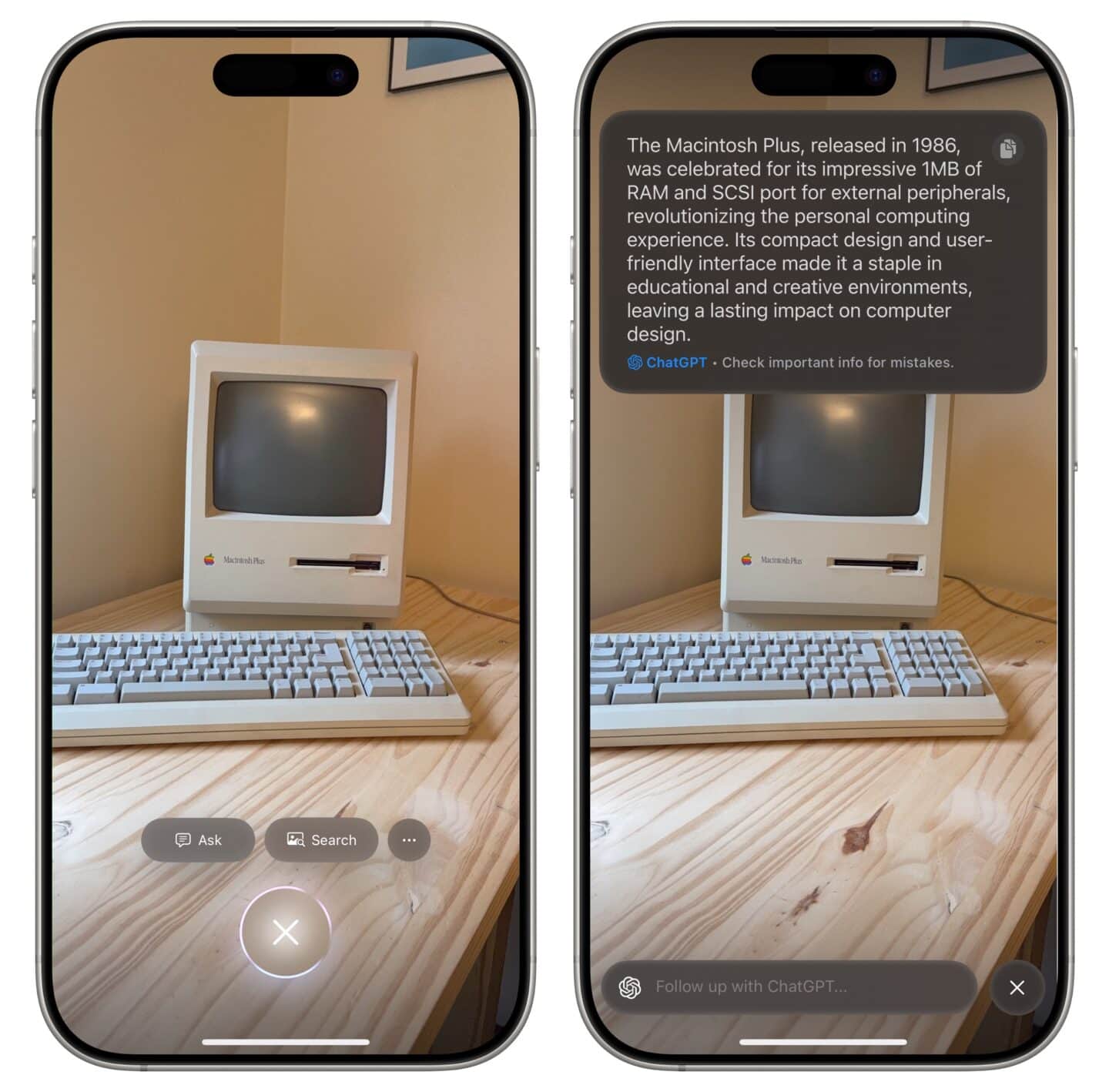

Nachdem Sie auf die Kamerasteuerung geklickt und diese gedrückt gehalten haben, sehen Sie eine kurze Animation und eine Benutzeroberfläche, die der iPhone-Kamera ähnelt, jedoch über weniger Bedienelemente verfügt.

Schauen Sie nach, indem Sie ein Foto machen

Screenshot: D. Griffin Jones/Cult of Mac

Klicken Sie erneut auf die Kamerasteuerung oder tippen Sie auf eine der Schaltflächen auf dem Bildschirm, um nachzusehen, was gerade angezeigt wird. Die folgenden zwei Optionen stehen immer zur Verfügung:

- Fragen sendet das Bild an ChatGPT. Der Chatbot von OpenAI kann möglicherweise erklären, was Sie sehen, und Sie können ihm weitere Fragen stellen, um weitere Informationen zu erhalten. Als ich das mit einer Reihe seltsamer Objekte in meinem Büro ausprobierte, war ich ziemlich beeindruckt von dem, was ChatGPT richtig gemacht hat, aber natürlich sind mir auch ein paar Fehler aufgefallen. Sie können ChatGPT nicht völlig als Ihre einzige Informationsquelle vertrauen; Sie sollten immer die Fakten überprüfen, um festzustellen, ob etwas Wichtiges vorliegt.

- Suchen verwendet eine umgekehrte Google-Bildsuche, um das Objekt zu identifizieren. Dies erweist sich als nützlich, wenn Sie ein Produkt oder Objekt online finden möchten. Tippen Sie auf ein Ergebnis, um den Link in Safari (oder Ihrem bevorzugten Webbrowser) zu öffnen.

Weitere intelligente kontextabhängige Visual Intelligence-Funktionen

Screenshot: D. Griffin Jones/Cult of Mac

Die anderen intelligenten Funktionen von Visual Intelligence sind stärker kontextabhängig:

- Veranstaltungen: Sie können die Kamera Ihres iPhone 16 auf etwas mit Veranstaltungsinformationen richten, beispielsweise ein Poster oder ein Dokument, und das Ereignis schnell zu Ihrem Kalender hinzufügen. Wenn es sich um ein Musikfestival oder ein Konzert handelt, ordnet das Tool es möglicherweise einem Ereignis zu und füllt die Details aus. Meine bisherigen Tests hierzu ergaben lückenhafte Ergebnisse, aber ich konnte es nicht wirklich gründlich testen. Es könnte superpraktisch werden.

- Unternehmen: Machen Sie ein Foto von einem Restaurant und Visual Intelligence verweist auf Ihren Standort mit Apple Maps-Informationen, um das Restaurant oder Unternehmen zu finden, das Sie gerade betrachten. Sie können eine Telefonnummer, eine Website, ein Menü und mehr sehen. Das scheint sich als unglaublich nützlich erweisen zu können. Wenn Sie die Straße entlanggehen und entscheiden, wo Sie essen möchten, können Sie möglicherweise schnell Informationen abrufen, ohne manuell nach jedem Namen suchen zu müssen, den Sie sehen.

Wie funktioniert visuelle Intelligenz?

Technisch gesehen ist keine dieser Visual-Intelligence-Funktionen besonders intelligent. ChatGPT und Google Reverse Image Search sind beide Dienste von Drittanbietern. Das Abrufen von Informationen wie Ereignissen und Telefonnummern aus der iPhone-Kamera basiert auf Live Text, einer Funktion, die das iPhone seit Jahren bietet. Und Visual Intelligence nutzt KI nicht viel, um Unternehmen zu identifizieren; Meistens nutzt es das GPS und den Kompass des iPhones mit Apple Maps – das kann jedes iPhone.

In der Praxis handelt es sich jedoch immer noch um nützliche und praktische Funktionen. Ich denke, wenn Apple Intelligence kein großer Marketing- und Branding-Anstoß wäre, würde Apple dies offener als eine praktische Neuverpackung verschiedener Dienste von Drittanbietern bezeichnen, anstatt es als neue KI-Technologie darzustellen.

Weitere Apple Intelligence-Funktionen

- So verwenden Sie die Schreibtools von Apple Intelligence

- Entfernen Sie mit Apple Intelligence ein Objekt aus einem Foto

- Praktische Erfahrungen mit den ersten 10 Apple Intelligence-Funktionen

- So erhalten Sie frühzeitig Apple Intelligence-Funktionen – und das in der EU