Warum die Verwendung eines Protokollanalysators für große Websites ein Muss ist

Dieser Beitrag wurde von JetOctopus gesponsert. Die in diesem Artikel geäußerten Meinungen sind die des Sponsors.

Wenn Sie eine große Website mit über 10.000 Seiten verwalten, können Sie wahrscheinlich die besonderen SEO-Herausforderungen nachvollziehen, die eine solche Größenordnung mit sich bringt.

Natürlich sind die traditionellen Tools und Taktiken – Keyword-Optimierung, Linkaufbau usw. – wichtig, um eine solide Grundlage zu schaffen und die grundlegende SEO-Hygiene aufrechtzuerhalten.

Sie werden jedoch möglicherweise nicht die technischen Komplexitäten von Site-Sichtbarkeit für Suchbots und die dynamischen Anforderungen einer großen Unternehmenswebsite.

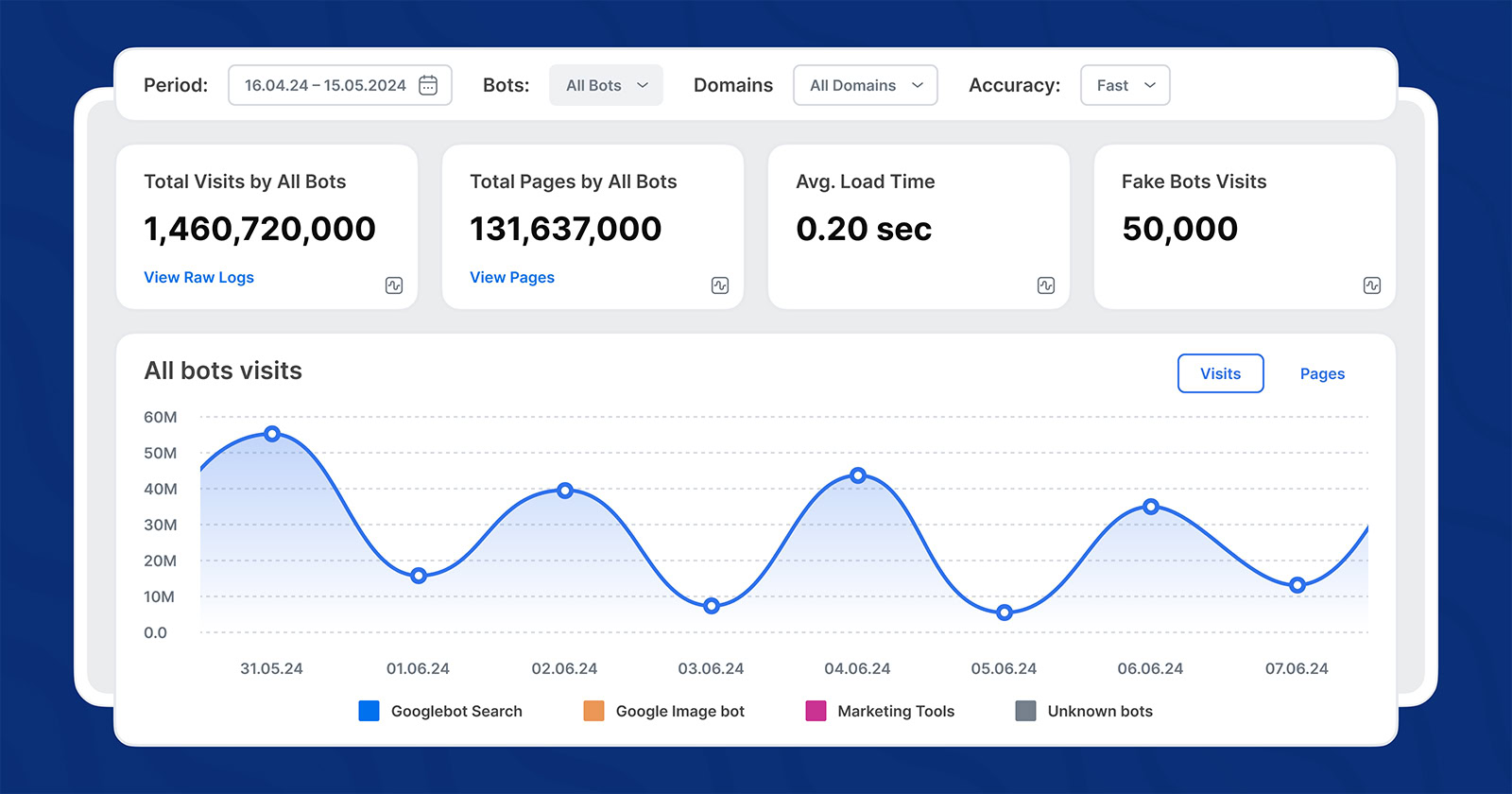

Hier werden Log-Analysatoren entscheidend. Ein SEO-Log-Analysator überwacht und analysiert Server-Zugriffsprotokolle, um Ihnen echte Einblicke in die Interaktion von Suchmaschinen mit Ihrer Website zu geben. Sie können damit strategische Maßnahmen ergreifen, die sowohl Suchcrawler als auch Benutzer zufriedenstellen, was zu einer höheren Rendite Ihrer Bemühungen führt.

In diesem Beitrag erfahren Sie, was ein Log-Analyzer ist und wie er Ihrer SEO-Strategie zu nachhaltigem Erfolg verhelfen kann. Doch zunächst wollen wir kurz darauf eingehen, was SEO für große Websites mit Tausenden von Seiten so schwierig macht.

Die einzigartigen SEO-Herausforderungen für große Websites

Die Verwaltung der SEO für eine Website mit über 10.000 Seiten ist nicht nur ein größerer Schritt, sondern eine völlig neue Sache.

Wenn Sie sich auf traditionelle SEO-Taktiken verlassen, begrenzt das Potenzial Ihrer Website für organisches Wachstum. Sie können die besten Titel und Inhalte auf Ihren Seiten haben, aber wenn Googlebot Wenn sie nicht effektiv gecrawlt werden können, werden diese Seiten ignoriert und möglicherweise nie eingestuft.

Bild erstellt von JetOctopus, Mai 2024

Bild erstellt von JetOctopus, Mai 2024Bei großen Websites ist es aufgrund der schieren Menge an Inhalten und Seiten schwierig, sicherzustellen, dass jede (wichtige) Seite für die Sichtbarkeit für Googlebot optimiert ist. Die zusätzliche Komplexität einer aufwendigen Site-Architektur führt dann oft zu erheblichen Crawl-Budget Probleme. Das bedeutet, dass Googlebot beim Crawlen wichtige Seiten übersieht.

Bild erstellt von JetOctopus, Mai 2024

Bild erstellt von JetOctopus, Mai 2024Darüber hinaus sind große Websites anfälliger für technische Störungen – wie unerwartete Änderungen am Code durch das Entwicklerteam –, die sich auf die SEO auswirken können. Dies verschärft oft andere Probleme wie langsame Seitengeschwindigkeiten aufgrund von umfangreichem Inhalt, defekten Links in großen Mengen oder redundanten Seiten, die um dieselben Keywords konkurrieren (Keyword-Kannibalisierung).

Alles in allem erfordern diese mit der Größe verbundenen Probleme einen robusteren SEO-Ansatz. Einen, der sich an die dynamische Natur großer Websites anpassen kann und sicherstellt, dass jede Optimierungsmaßnahme sinnvoller ist, um das ultimative Ziel einer verbesserten Sichtbarkeit und Steigerung des Datenverkehrs zu erreichen.

Bei dieser strategischen Verschiebung wird die Leistungsfähigkeit eines SEO-Log-Analyzers deutlich, der detaillierte Einblicke liefert, die dabei helfen, wirkungsvolle Maßnahmen zu priorisieren. Die wichtigste Maßnahme besteht darin, den Googlebot besser zu verstehen, als wäre er der Hauptnutzer Ihrer Website – solange Ihre wichtigen Seiten nicht von Googlebot aufgerufen werden, werden sie nicht eingestuft und generieren keinen Traffic.

Was ist ein SEO-Log-Analyzer?

Ein SEO-Log-Analyzer ist im Wesentlichen ein Tool, das die von Webservern bei jeder Seitenanforderung generierten Daten verarbeitet und analysiert. Es verfolgt, wie Suchmaschinen-Crawler mit einer Website interagieren, und bietet wichtige Einblicke in das, was hinter den Kulissen passiert. Ein Log-Analyzer kann feststellen, welche Seiten gecrawlt werden, wie oft und ob Crawling-Probleme auftreten, z. B. wenn Googlebot nicht auf wichtige Seiten zugreifen kann.

Durch die Analyse dieser Serverprotokolle helfen Protokollanalysatoren SEO-Teams zu verstehen, wie eine Website tatsächlich von Suchmaschinen gesehen wird. Dadurch können sie präzise Anpassungen vornehmen, um die Website-Leistung zu verbessern, die Crawling-Effizienz zu steigern und letztendlich die SERP-Sichtbarkeit zu verbessern.

Einfach ausgedrückt hilft ein tiefer Einblick in die Protokolldaten dabei, Möglichkeiten zu entdecken und Probleme zu erkennen, die bei großen Websites sonst möglicherweise unbemerkt bleiben würden.

Aber warum genau sollten Sie Ihre Bemühungen darauf konzentrieren, Googlebot als Ihren wichtigsten Besucher zu behandeln?

Warum ist das Crawl-Budget so wichtig?

Schauen wir uns das an.

Optimierung des Crawl-Budgets für maximale SEO-Wirkung

Das Crawl-Budget bezeichnet die Anzahl der Seiten, die ein Suchmaschinen-Bot (z. B. Googlebot) innerhalb eines bestimmten Zeitraums auf Ihrer Website crawlen wird. Sobald das Budget einer Website aufgebraucht ist, beendet der Bot das Crawlen und wechselt zu anderen Websites.

Crawl-Budgets sind für jede Website unterschiedlich und das Budget Ihrer Website wird von Google selbst bestimmt, wobei verschiedene Faktoren wie Größe, Leistung, Aktualisierungshäufigkeit und Links der Website berücksichtigt werden. Wenn Sie sich auf die strategische Optimierung dieser Faktoren konzentrieren, können Sie Ihr Crawl-Budget erhöhen und das Ranking für neue Website-Seiten und -Inhalte beschleunigen.

Wie zu erwarten, sorgt die optimale Ausnutzung dieses Budgets dafür, dass Ihre wichtigsten Seiten häufig besucht und vom Googlebot indexiert werden. Dies führt in der Regel zu besseren Rankings (vorausgesetzt, Ihre Inhalte und die Benutzererfahrung sind solide).

Und hier erweist sich ein Protokollanalysetool als besonders nützlich, da es detaillierte Einblicke in die Interaktion der Crawler mit Ihrer Site bietet. Wie bereits erwähnt, können Sie damit sehen, welche Seiten wie oft gecrawlt werden. So können Sie Ineffizienzen wie Seiten mit geringem Wert oder irrelevante Seiten, die wertvolle Crawl-Ressourcen verschwenden, identifizieren und beheben.

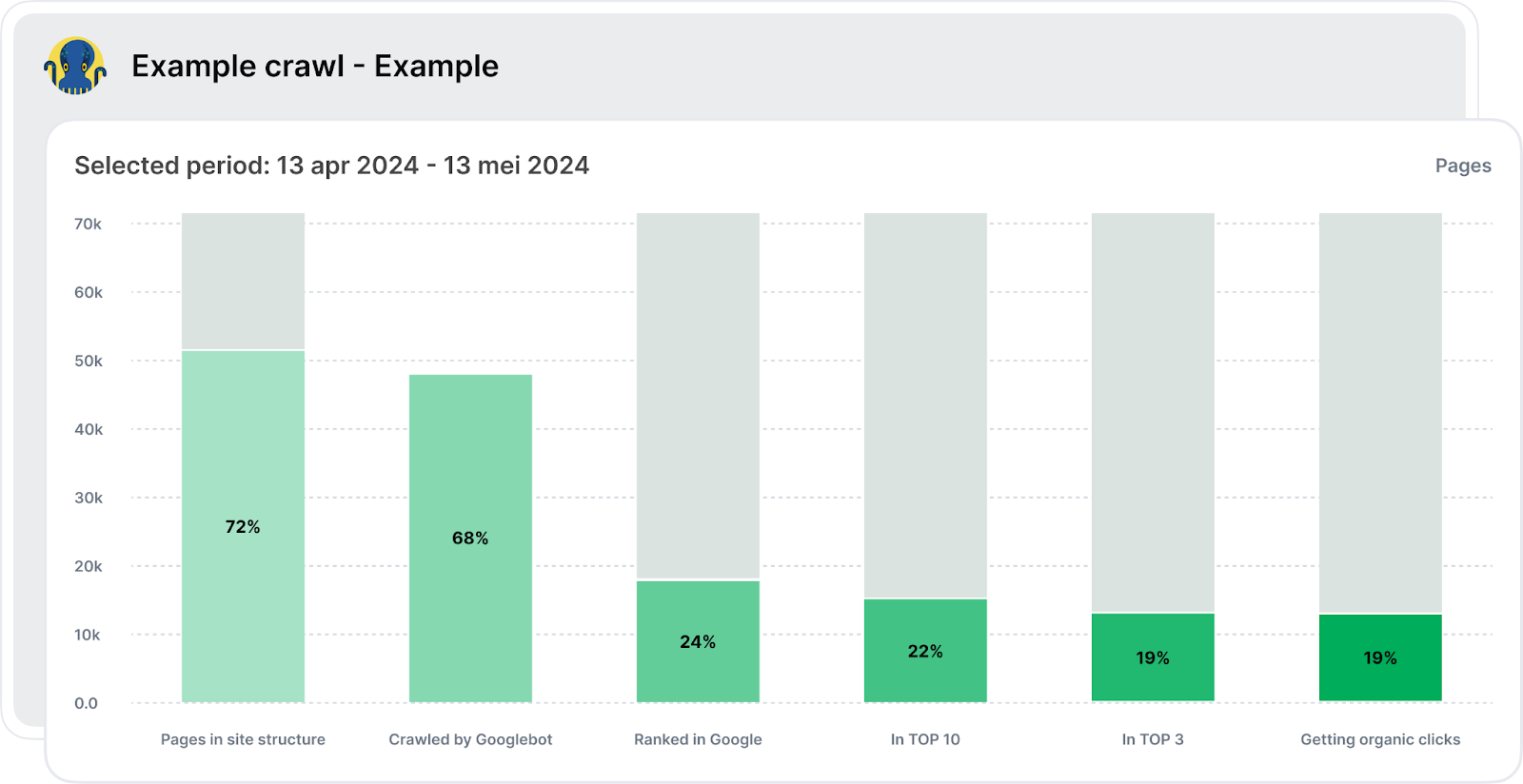

Ein fortschrittlicher Log-Analysator wie JetOctopus bietet eine vollständige Übersicht über alle Phasen vom Crawling und der Indexierung bis hin zum Erhalt organischer Klicks. SEO-Trichter deckt alle wichtigen Phasen ab, vom Besuch Ihrer Website durch Googlebot bis hin zur Platzierung in den Top 10 und der Generierung von organischem Traffic.

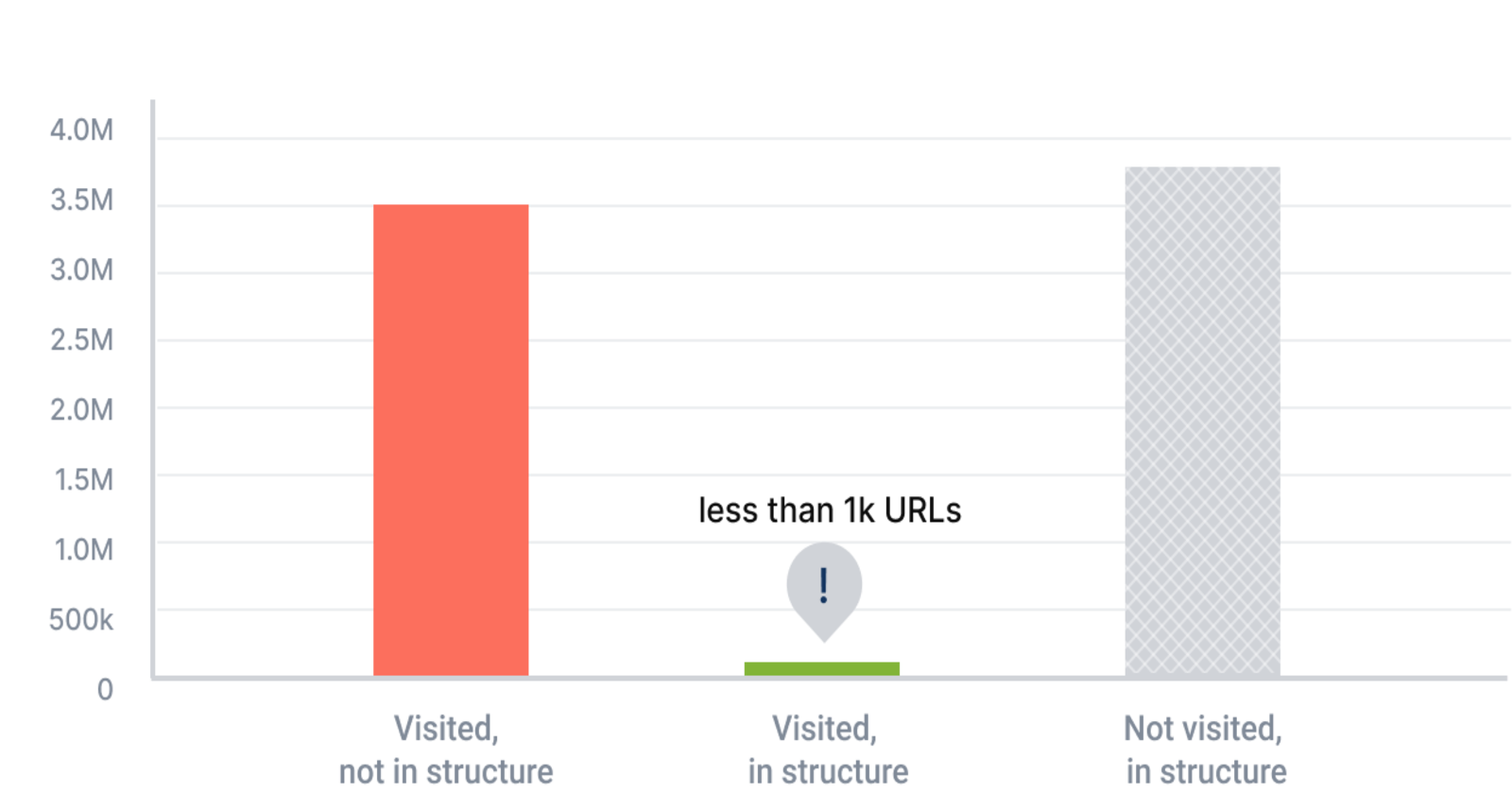

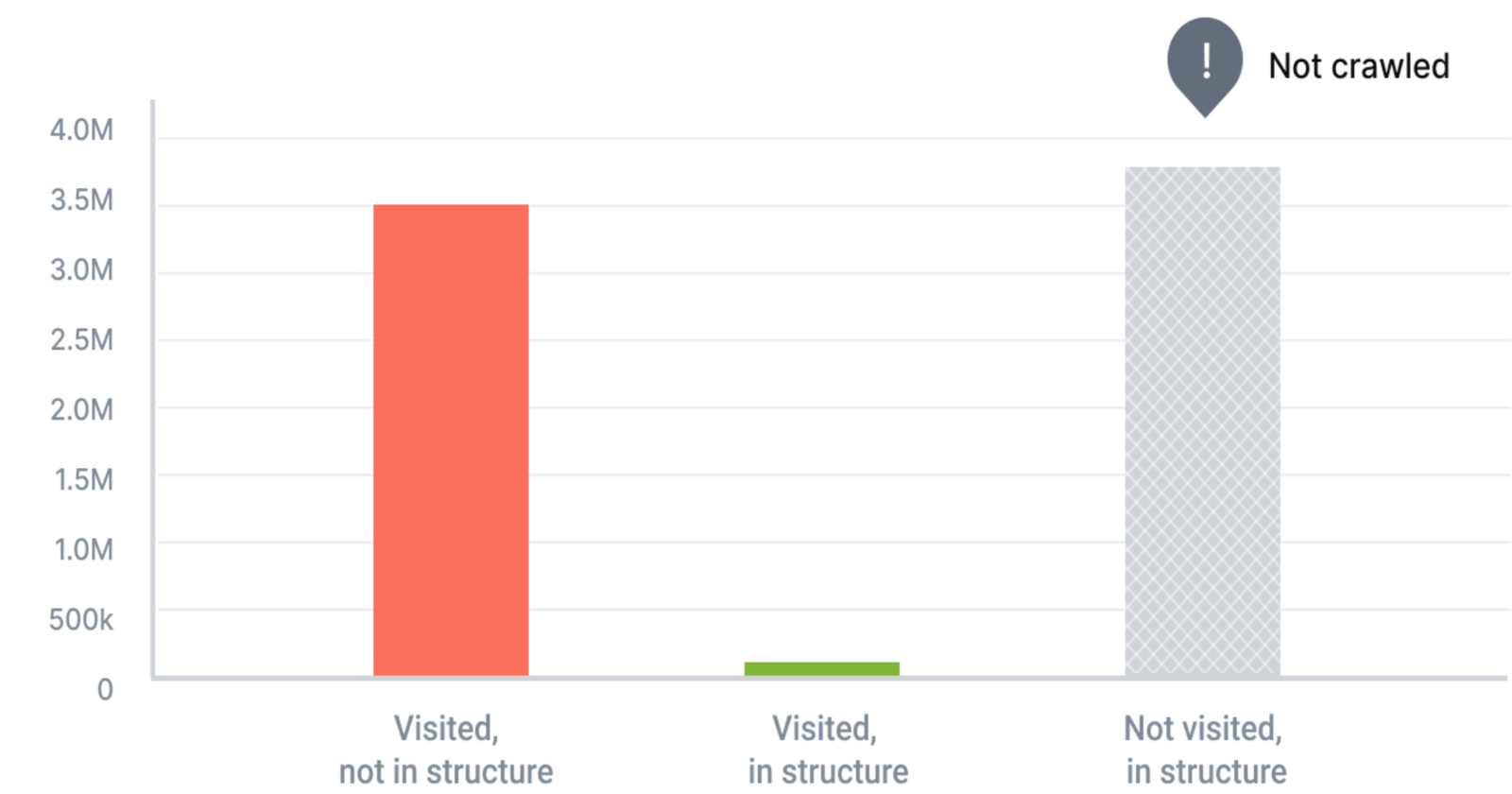

Bild erstellt von JetOctopus, Mai 2024

Bild erstellt von JetOctopus, Mai 2024Wie Sie oben sehen können, zeigt die tabellarische Ansicht, wie viele Seiten zur Indexierung geöffnet sind und wie viele von der Indexierung ausgeschlossen wurden. Dieses Verhältnis zu kennen ist entscheidend, denn wenn kommerziell wichtige Seiten von der Indexierung ausgeschlossen werden, erscheinen sie in den nachfolgenden Phasen des Funnels nicht.

Im nächsten Schritt wird die Anzahl der von Googlebot gecrawlten Seiten untersucht. „Grüne Seiten“ stehen für die gecrawlten Seiten innerhalb der Struktur, während „graue Seiten“ auf eine mögliche Verschwendung des Crawl-Budgets hinweisen, da sie von Googlebot besucht werden, sich aber nicht innerhalb der Struktur befinden. Es kann sich um verwaiste Seiten handeln oder um Seiten, die versehentlich aus der Struktur ausgeschlossen wurden. Daher ist es wichtig, diesen Teil Ihres Crawl-Budgets zu analysieren, um eine Optimierung zu erzielen.

In den späteren Phasen wird analysiert, wie viel Prozent der Seiten in den SERPs von Google gerankt sind, wie viele dieser Rankings in den Top 10 oder Top 3 liegen und schließlich wie viele Seiten organische Klicks erhalten.

Insgesamt liefert Ihnen der SEO-Funnel konkrete Zahlen mit Links zu URL-Listen für weitere Analysen, beispielsweise indexierbare und nicht indexierbare Seiten und wie viel Crawl-Budget verschwendet wird. Er ist ein hervorragender Ausgangspunkt für die Crawl-Budget-Analyse, da er Ihnen einen Überblick über das große Ganze verschafft und Einblicke für einen wirkungsvollen Optimierungsplan liefert, der spürbares SEO-Wachstum ermöglicht.

Einfach ausgedrückt: Indem Sie Seiten mit hohem Wert priorisieren – und sicherstellen, dass sie fehlerfrei und für Suchbots leicht zugänglich sind – können Sie die Sichtbarkeit und das Ranking Ihrer Site erheblich verbessern.

Mithilfe eines SEO-Log-Analyzers können Sie genau verstehen, was auf Seiten optimiert werden sollte, die von Crawlern ignoriert werden, daran arbeiten und so Besuche des Googlebots anziehen. Ein Log-Analyzer ist hilfreich bei der Optimierung anderer wichtiger Aspekte Ihrer Website:

Bild erstellt von JetOctopus, Mai 2024

Bild erstellt von JetOctopus, Mai 2024- Detaillierte Analyse des Bot-Verhaltens: Mithilfe von Protokollanalysatoren können Sie analysieren, wie Suchbots mit Ihrer Site interagieren, indem Sie Faktoren wie die Tiefe ihres Crawlings, die Anzahl der internen Links auf einer Seite und die Wortanzahl pro Seite untersuchen. Diese detaillierte Analyse liefert Ihnen die genauen Aufgaben zur Optimierung der SEO-Leistung Ihrer Site.

- Verbessert die interne Verlinkung und die technische Leistung: Protokollanalysatoren bieten detaillierte Einblicke in die Struktur und den Zustand Ihrer Site. Sie helfen dabei, Seiten mit schlechter Leistung zu identifizieren und die Platzierung interner Links zu optimieren, um eine reibungslosere Benutzer- und Crawler-Navigation zu gewährleisten. Sie erleichtern auch die Feinabstimmung von Inhalten, um SEO-Standards besser zu erfüllen, und heben technische Probleme hervor, die die Geschwindigkeit und Zugänglichkeit der Site beeinträchtigen können.

- Hilft bei der Fehlerbehebung bei JavaScript- und Indexierungsproblemen: Große Websites, insbesondere E-Commerce-Websites, verlassen sich oft stark auf JavaScript für dynamische Inhalte. Bei JS-Websites ist der Crawling-Prozess langwierig. Ein Log-Analyzer kann verfolgen, wie gut Suchmaschinen-Bots JavaScript-abhängige Inhalte rendern und indexieren können, und potenzielle Fallstricke in Echtzeit aufzeigen. Er identifiziert auch Seiten, die nicht wie beabsichtigt indexiert werden, und ermöglicht so zeitnahe Korrekturen, um sicherzustellen, dass alle relevanten Inhalte ein Ranking erhalten.

- Hilft bei der Optimierung der Distanz vom Index (DFI): Das Konzept der Distanz vom Index (DFI) bezieht sich auf die Anzahl der Klicks, die erforderlich sind, um von der Startseite aus eine beliebige Seite zu erreichen. Eine niedrigere DFI ist im Allgemeinen besser für SEO, da wichtige Inhalte sowohl von Benutzern als auch von Suchmaschinen-Crawlern leichter gefunden werden können. Protokollanalysatoren helfen dabei, die Navigationsstruktur Ihrer Site abzubilden und schlagen Änderungen vor, die die DFI reduzieren und die allgemeine Zugänglichkeit wichtiger Inhalte und Produktseiten verbessern können.

Darüber hinaus können die historischen Protokolldaten, die ein Protokollanalysator bereitstellt, von unschätzbarem Wert sein. Sie helfen Ihnen, Ihre SEO-Leistung nicht nur verständlich, sondern auch vorhersehbar zu machen. Durch die Analyse vergangener Interaktionen können Sie Trends erkennen, zukünftige Probleme vorhersehen und effektivere SEO-Strategien planen.

Mit JetOctopus profitieren Sie von keinen Volumenbeschränkungen für Protokolle, was eine umfassende Analyse ermöglicht, ohne dass Sie befürchten müssen, wichtige Daten zu verpassen. Dieser Ansatz ist von grundlegender Bedeutung, um Ihre Strategie kontinuierlich zu verfeinern und den Spitzenplatz Ihrer Website in der sich schnell entwickelnde Landschaft der Suche.

Erfolge in der Praxis durch den Einsatz von Log Analyzer

Große Websites in verschiedenen Branchen haben Protokollanalysatoren genutzt, um bei profitablen Schlüsselwörtern Spitzenplätze bei Google zu erreichen und zu halten, was erheblich zu ihrem Geschäftswachstum beigetragen hat.

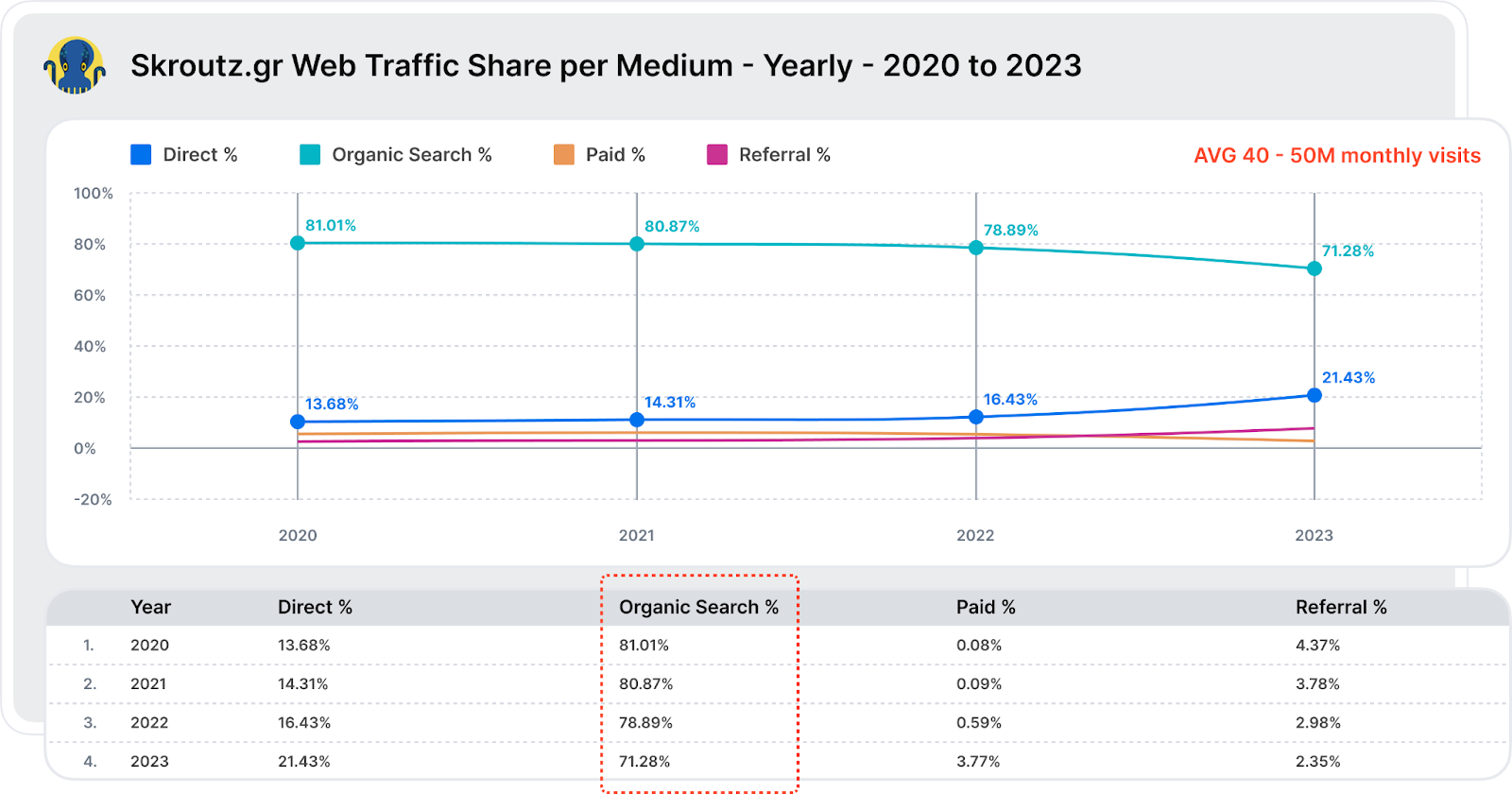

Skroutz beispielsweise, Griechenlands größte Marktplatz-Website mit über 1 Million Sitzungen täglich, hat ein Echtzeit-Crawling- und Log-Analyzer-Tool eingerichtet, mit dem das Unternehmen Dinge wie die folgenden ermitteln konnte:

- Crawlt Googlebot Seiten, auf denen mehr als zwei Filter aktiviert sind?

- Wie umfangreich crawlt der Googlebot eine besonders beliebte Kategorie?

- Was sind die wichtigsten URL-Parameter, die Googlebot crawlt?

- Besucht Googlebot Seiten mit Filtern wie „Größe“, die normalerweise als „Nofollow“ markiert sind?

Diese Möglichkeit, Visualisierungstabellen und historische Protokolldaten über einen Zeitraum von mehr als zehn Monaten in Echtzeit anzuzeigen und so Googlebot-Crawls zu überwachen, ermöglichte es Skroutz, Crawling-Schlupflöcher zu finden und die Indexgröße zu verringern, wodurch sein Crawling-Budget optimiert wurde.

Schließlich konnten sie auch feststellen, dass die Zeit für die Indizierung und Rangfolge neuer URLs verkürzt wurde – statt 2–3 Monaten dauerte die Indizierungs- und Rangfolgephase neuer URLs nur noch wenige Tage.

Dieser strategische Ansatz zur technischen SEO unter Verwendung von Protokolldateien hat Skroutz dabei geholfen, seine Position als eine der 1.000 Top-Websites weltweit (laut SimilarWeb) und als viertmeistbesuchte Website in Griechenland (nach Google, Facebook und YouTube) zu festigen, wobei über 70 % des Datenverkehrs aus der organischen Suche stammen.

Bild erstellt von JetOctopus, Mai 2024

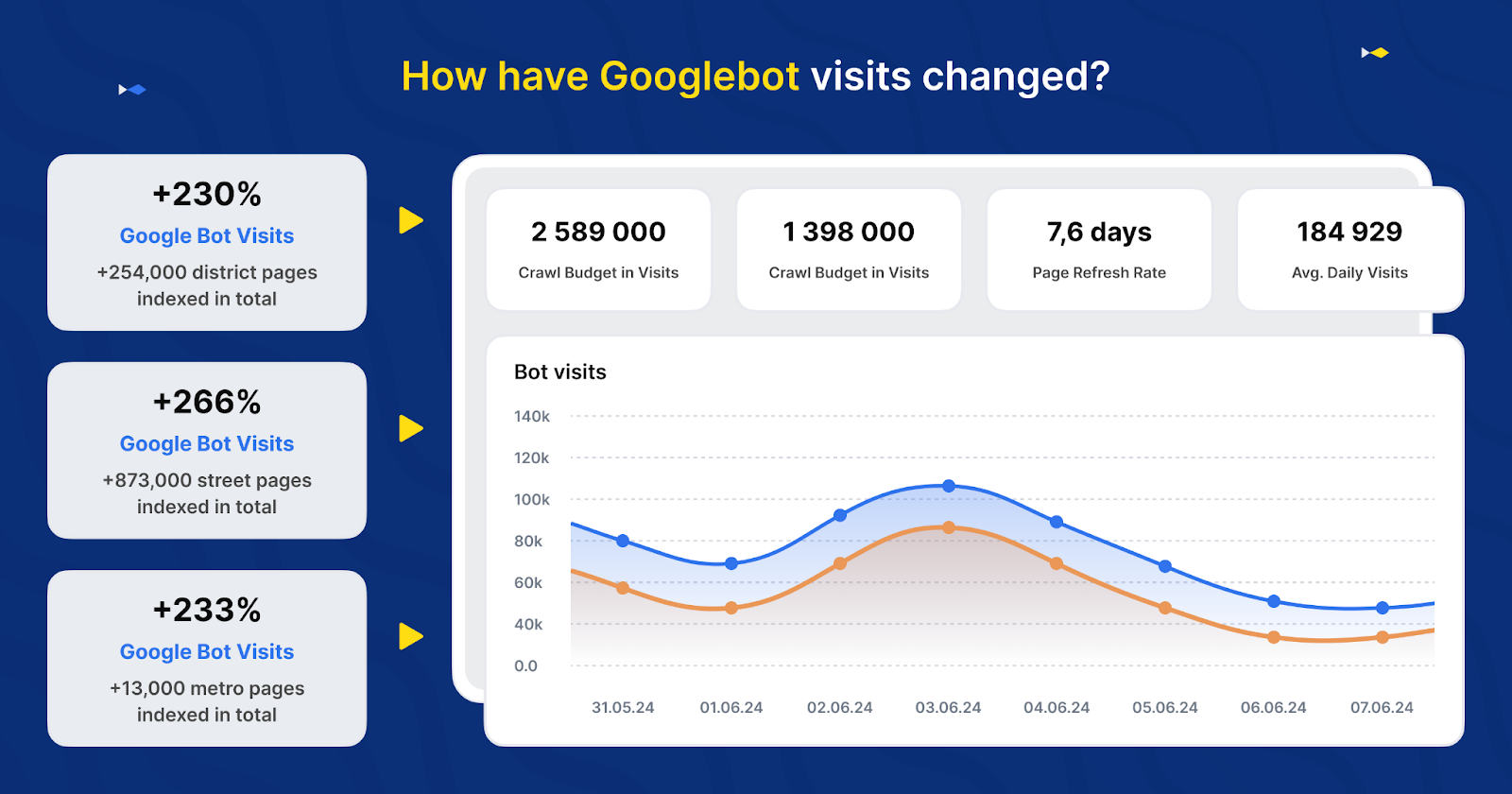

Bild erstellt von JetOctopus, Mai 2024Ein weiteres Beispiel ist DOM.RIA, die beliebte ukrainische Website für Immobilien- und Mietangebote, die die Besuche des Googlebot verdoppelte, indem sie die Crawling-Effizienz ihrer Website optimierte. Da die Struktur ihrer Website riesig und komplex ist, musste die Crawling-Effizienz für den Googlebot optimiert werden, um die Aktualität und Relevanz der in Google angezeigten Inhalte sicherzustellen.

Zunächst implementierten sie eine neue Sitemap, um die Indizierung tieferer Verzeichnisse zu verbessern. Trotz dieser Bemühungen blieben die Besuche durch den Googlebot gering.

Durch die Verwendung von JetOctopus zur Analyse der Protokolldateien konnte DOM.RIA Probleme mit der internen Verlinkung und DFI identifizieren und beheben. Anschließend erstellten sie Mini-Sitemaps für schlecht gescannte Verzeichnisse (z. B. für die Stadt, einschließlich URLs für Straßen, Bezirke, U-Bahn usw.) und wiesen Meta-Tags mit Links zu Seiten zu, die der Googlebot häufig besucht. Diese strategische Änderung führte innerhalb von zwei Wochen zu einer mehr als Verdoppelung der Googlebot-Aktivität auf diesen wichtigen Seiten.

Bild erstellt von JetOctopus, Mai 2024

Bild erstellt von JetOctopus, Mai 2024Erste Schritte mit einer SEO-Log-Analyse zer

Nachdem Sie nun wissen, was ein Protokollanalysator ist und was er für große Websites leisten kann, werfen wir einen kurzen Blick auf die Schritte der Protokollanalyse.

Hier ist eine Übersicht über die Verwendung eines SEO-Log-Analysators wie JetOctopus für Ihre Website:

- Integrieren Sie Ihre Protokolle: Beginnen Sie damit, Ihre Serverprotokolle mit einem Protokollanalysetool zu integrieren. Dieser Schritt ist entscheidend, um alle Daten zu erfassen, die mit Site-Besuchen in Zusammenhang stehen, einschließlich aller Anfragen an den Server.

- Identifizieren Sie die wichtigsten Probleme: Verwenden Sie den Protokollanalysator, um schwerwiegende Probleme wie Serverfehler (5xx), langsame Ladezeiten und andere Anomalien aufzudecken, die sich auf die Benutzererfahrung und die Site-Leistung auswirken könnten. In diesem Schritt werden große Datenmengen gefiltert und sortiert, um sich auf Probleme mit schwerwiegenden Auswirkungen zu konzentrieren.

- Beheben Sie die Probleme: Sobald Probleme identifiziert sind, priorisieren und beheben Sie diese, um die Zuverlässigkeit und Leistung der Site zu verbessern. Dies kann das Reparieren defekter Links, das Optimieren langsam ladender Seiten und das Korrigieren von Serverfehlern umfassen.

- Kombinieren Sie mit Crawl-Analyse: Führen Sie Protokollanalysedaten mit Crawl-Daten zusammen. Diese Integration ermöglicht einen tieferen Einblick in die Analyse und Optimierung des Crawl-Budgets. Analysieren Sie, wie Suchmaschinen Ihre Site crawlen, und passen Sie Ihre SEO-Strategie an, um sicherzustellen, dass Ihre wertvollsten Seiten ausreichend Aufmerksamkeit von Suchbots erhalten.

Und so können Sie sicherstellen, dass Suchmaschinen Ihre wichtigsten Inhalte effizient indizieren.

Abschluss

Wie Sie sehen, ist der strategische Einsatz von Log-Analyzern mehr als nur eine technische Notwendigkeit für große Websites. Die Optimierung der Crawling-Effizienz Ihrer Website mit einem Log-Analyzer kann Ihre SERP-Sichtbarkeit enorm beeinflussen.

Für CMOs, die große Websites verwalten, ist ein Log-Analyzer und Crawler-Toolkit wie JetOctopus ist, als ob Sie einen zusätzlichen technischen SEO-Analysten bekommen, der die Lücke zwischen SEO-Datenintegration und organischem Verkehrswachstum schließt.

Bildnachweise

Vorgestelltes Bild: Bild von JetOctopus. Mit Genehmigung verwendet.